Тесты эффективности SLI: GTX 280 SLI против 9800 GX2 Quad SLI.

Достаточно интересным является сравнение эффективности SLI – да, 9800 GX2 в большинстве тестов превосходит одиночную GeForce GTX 280. При этом GX2 уже сама по себе, как мы упоминали выше, является SLI решением. Насколько эффективной окажется связка из двух GTX 280 против Quad SLI из 9800 GX2? Ведь хорошо известно, что если прирост от добавления в систему второй видеокарты в большинстве случаев оправдывает ее стоимость, то системы класса Quad SLI это уже решения для энтузиастов.

Кстати, не забывайте и о том, что тестируемые карты имею очень высокий уровень энергопотребления – NVIDIA рекомендует БП на 1200 Вт для пары GTX 280. Остается только догадываться, какие мощности будут потреблять карты, объединенные в 3-way SLI.

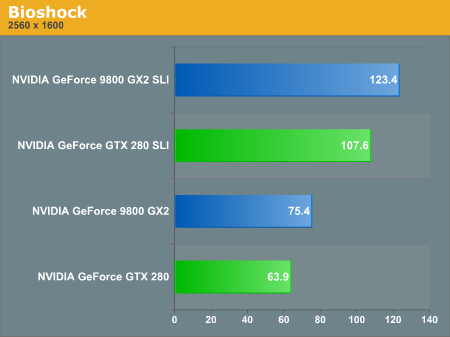

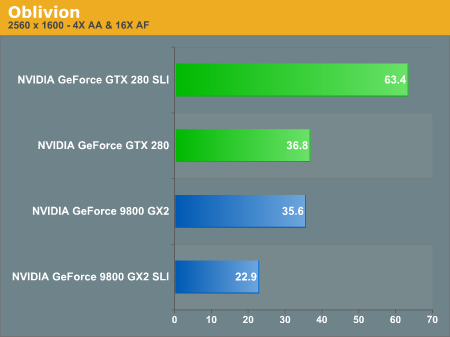

Обратимся к результатам тестирования:

| | GTX 280 SLI (прирост производительности при переходе от одной карты к двум) | 9800 GX2 SLI

(прирост производительности при переходе от одной карты к двум) | | Crysis | 50.1% | 30.3% | | Call of Duty 4 | 62.8% | 64.0% | | Assassin's Creed | 38.9% | 12.7% | | The Witcher | 54.9% | 36.2% | | Bioshock | 68.4% | 63.7% | | Oblivion | 72.3% | -35.7% |

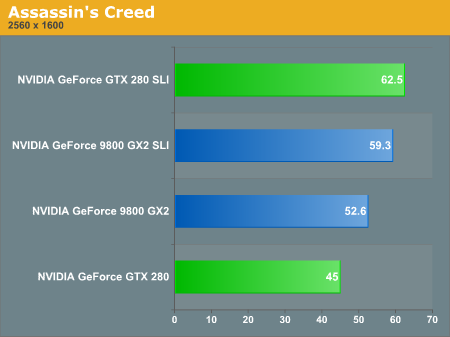

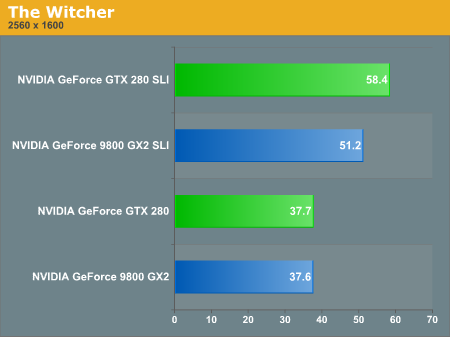

Crysis, Assassin’s Creed, The Witcher, Oblivion – все эти игры показывают несуразность решения Quad SLI, производительность либо не возрастает, либо вообще снижается при добавлении второй GeForce 9800 GX2. Напротив, две GTX 280 показывают себя очень неплохо.

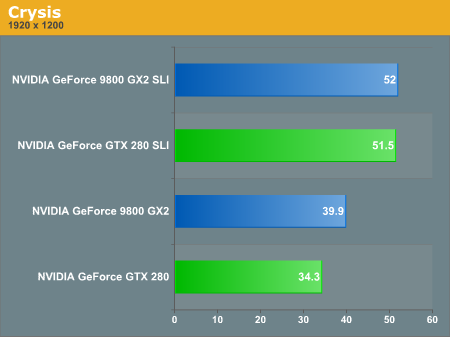

Crysis является наглядным примером такого поведения. Из-за посредственной масштабируемости Quad SLI, пара GTX 280 оказывается вполне способной противостоять четырем чипам G92, хотя одиночные карты вели себя по-другому.

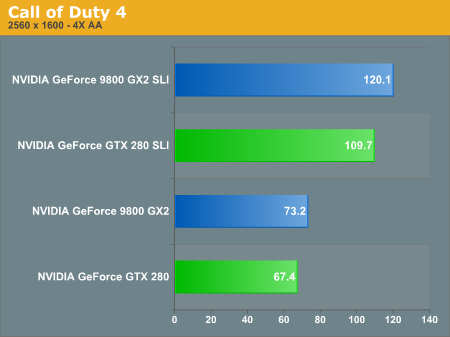

Но не везде все так грустно, и когда Quad SLI раскрывается в полную силу, производительности двух GTX 280 уже недостаточно, чтобы победить такую связку.

На нижеследующих тестах вы найдете подтверждения наших слов о том, что многочиповые решения SLI не лишены недостатков.

Логично сделать вывод, что если рекомендовать к покупке одиночную GTX 280 проблематично, то если рассматривать SLI решения пара таких видеокарт будет смотреться лучше Quad SLI на базе GeForce 9800 GX2.

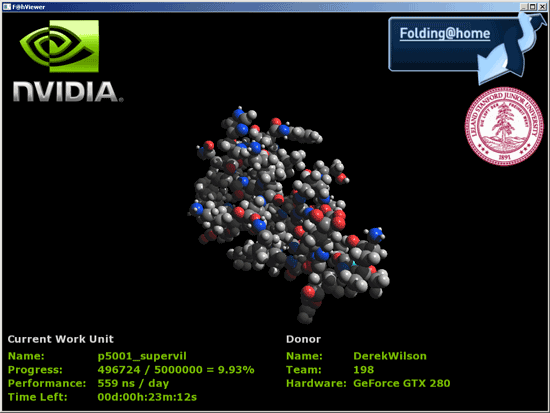

[N20-Folding@home – теперь и на видеокартах NVIDIA.]

Все большее и большее распространение сегодня получают проекты распределенных вычислений, и F@h является одним из них. Основной целью является компьютерная симуляция протеинового фолдинга, т.е. свертывания/развертывания молекул белка. Анализ результатов такого моделирования помогает ученым понять причины возникновения болезней, причиной которых служат дефектные белки. Это и болезнь Альцгеймера, Паркинсона, склероз и диабет... Однако такие расчеты очень ресурсоемки и требуют огромных математических ресурсов. Как вариант решения было предложено разбивать одну большую задачу на множество мелких, передавая их энтузиастам для расчетов, а потом собирать результаты воедино.

Изначально клиентские программы поддерживали расчеты в F@h только силами центральных процессоров, потом была добавлена поддержка видеокарт AMD, свой клиент получила даже PlayStation 3 на базе мощного Cell’а. NVIDIA некоторое время оставалась в стороне, но недавно было объявлено, что и на платформе CUDA реализован вариант Folding’а для семейств GeForce, основанных на G80 и выше. Конечно, GT200 поддерживается в полной мере, и именно он со своей огромной вычислительной мощью в программе F@h становится одним из самых производительных аппаратных решений для расчетов фолдинга.

Хотя видеокарты и процессоры в Folding@home используются для несколько различных целей, напрямую можно сравнить время жизни белка, которое синтезируется за день вычислений. Если для четырехядерного процессора нормой является несколько десятков нс, то GT200 на порядок превосходит эту величину, рассчитывая сотни нс в день.

По прогнозам NVIDIA конкретные цифры должны были составлять порядка 500-600 нс, в своих же тестах мы видел даже лучшие результаты – от 600 до 850 нс. Для сравнения, показатели одиночного Radeon HD 3870 держатся на уровне 180 нс за день, а у PS 3 и того меньше – 100 нс.

В своих презентациях NVIDIA говорит о том, что было продано порядка 70 миллионов видеокарт, которые могут работать в Folding@home, притом средняя мощность каждой составляет 100 гигафлопс. Для получения огромной цифры в 70 петафлоп достаточно, чтобы лишь 1% энтузиастов захотел задействовать эти возможности. Сколько же вычислений из общей массы будет приходиться на видеокарты NVIDIA, покажет лишь время.

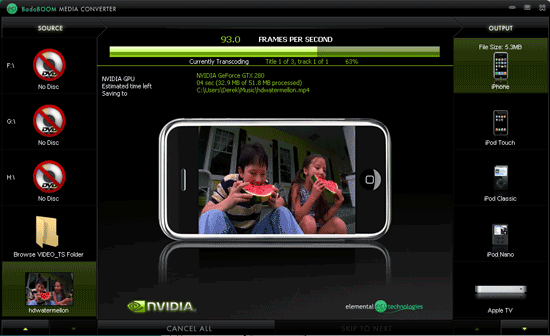

Аппаратная поддержка кодирования H.264.

Многие годы ATI и NVIDIA обещали пользователям золотые горы с возможностью кодирования видео силами видеокарт, однако ни разу эти обещания в полной мере не исполнялись. Похоже, что с GT200 приходит конец и невыполненным обещаниям. Во всяком случае, пока со стороны NVIDIA.

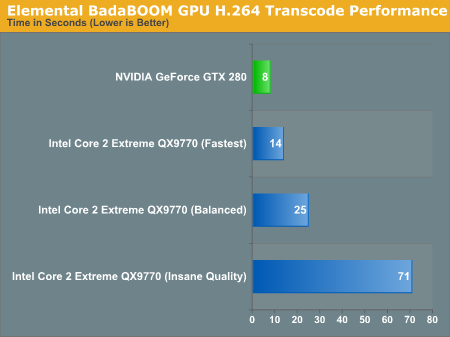

Так, наконец-то появилась первая реальная утилита, задействующая аппаратные возможности GPU для кодирования видео от Elemental Technologies с достаточно смешным названием – BadaBOOM Media Converter.

На данный момент программа работает только с GeForce GTX 280 и 260, однако это лишь бета-версия, и финальный релиз согласно обещаниям разработчиков обретет поддержку G80 и G92. К сожалению, так как BadaBOOM лишен поддержки кодирования видео средствами CPU, полностью объективное сравнение провести нельзя, и придется использовать дополнительные программы, к тому же во время кодирования видео процессор так же выполняет некоторую работу – загрузка находится на уровне 25-30%.

Тем не менее, результаты, показанные GTX 280 очень интересны. Для сравнения со скоростью кодирования CPU мы воспользовались бесплатной программой x264 encoder. Результаты получились следующими:

В самом худшем случае превосходство GTX 280 над Core 2 Extreme QX9770 составило 40%, тогда как в лучшем детище NVIDIA оказалось почти в 10 раз быстрее. Какие результаты были бы получены при абсолютно корректном сравнении, мы сказать затрудняемся, но даже если они близки к минимальному превосходству, полученному нами, это огромный прогресс в деле ускорения кодирования видео силами GPU.

[N21-Разогнанный GT200 с 4 Гб GDDR3 на борту: Tesla 10P.]

Завершая наш обзор GT200 нельзя не отметить и инициативу NVIDIA под кодовым названием Tesla. Если необходимо произвести специализированные вычисления именно средствами GPU, а мощности даже такого производительного решения, как GTX 280, недостаточно, NVIDIA есть, что предложить.

|

Вместе с анонсом домашних карт серии GeForce, NVIDIA представила и профессиональные решения нового поколения Tesla – C1060 Computing Processor. Плата основана на профессиональной модификации GT200, называемой T10P (конечно, кроме маркировки чип ничем не отличается), имеет повышенную до 1,5 ГГц частоту шейдерного домена и целых 4 Гб набортной памяти. Какие-либо порты ввода-вывода отсутствуют. Может вызвать недоумение, что серверная версия работает на более высоких тактовых частотах, однако объяснение тут простое – в датацентрах далеко не так важен шум, который производит турбина, а температура в охлаждаемых помещениях и серверных стойках ниже, чем в тесных корпусах домашних пользователей. Наличие же невероятного объема памяти необходимо исключительно для научных задач, на которые и нацелено устройство.

|

Предполагается возможность объединения четырех карт C1060 в одном сервере стандартной высоты 1U, тем самым становятся доступны суммарные 960 потоковых процессоров и 16 Гб памяти. В качестве связующих цепей используется стандартная PCI-Express. Основное предназначение такого сервера – обсчитывать задачи, написанные для платформы CUDA, а с учетом наличия общих 120 64-битных FPU, соответствующих стандарту IEEE 754r, получаться это должно очень хорошо.

Хотя мы и не обладаем инструментами для проверки производительности такой машины, по данным NVIDIA один GT200 при выполнении операция удвоенной точности с числами с плавающей запятой может быть сравним с 8-ми ядерным Xeon. Тогда сервер S1070 из четырех таких чипов находится на уровне 32 ядер Xeon, при этом потребляя около 700 Вт. Не стоит даже говорить о том, что операции с обычной точностью выполняются в разы быстрее и могут превосходить сотни обычных CPU.

Хотя обычные графические карты несоизмеримо дешевле, стоимость таких серверов не выглядит завышенной по сравнению с классическими решениями с учетом результирующей производительности. Да, они пригодны только для специализированной платформы CUDA, однако ресурсов NVIDIA вполне достаточно, чтобы сделать из узконаправленной платформы индустриальный стандарт. К тому же CUDA поддерживают и десятки миллионов проданных карт потребительского сегмента, что дает разработчикам возможность использовать их ресурсы для отладки приложений и последующего принятия решений о полноценном переходе на CUDA, а пользователям – огромную дополнительную производительность в сотни гигафлопс (в зависимости от поколения GPU), которая может быть затрачена отнюдь не только на визуализацию графики в играх.

|

Сегодня уже доступна CUDA-версия Folding@home, в скором времени появится и релиз кодировщика видео от Elemental Technologies. С учетом того, насколько эффективно они задействую возможности GPU, только представьте, насколько повысится эффективность работы профессиональных программ вроде ProTools или Premier, когда разработчики “научат” их работать под CUDA.

Конечно, на сегодня CUDA все еще очень специализирована и зависит только от одного вендора – NVIDIA. Хотя калифорнийцы и предоставили все возможности, например, AMD, принять участие в программе, последняя пока от этого отказалась. Конечно, какой резон компании, у которой и так не очень радужно финансовое положение, вкладывать деньги в пока еще сырую технологию, да еще и Intel не дремлет со своим x86 Larrabee... Однако все может измениться, если NVIDIA приложит усилия чтобы сертифицировать CUDA в рамках ISO или ANSI, и тогда, вполне возможно, будущее решится в пользу этой, без всяких сомнений, перспективной технологии.

[N22-Выводы и финальные слова.]

Не может возникнуть никаких сомнений в том, что NVIDIA спроектировала очень и очень впечатляющий чип. C огромным числом транзисторов в GT200 вложили невероятный объем вычислительной мощности. Звучит невероятно, но через 18 месяцев можно ожидать от NVIDIA очередного удвоение количества транзисторов, и что это получится за монстр даже сложно представить. Такими темпами мы совсем скоро переступим порог фотореалистичной графики, и именно такие сложные и производительные GPU, как GT200 в этом помогут.

Достаточно интересно и то, что AMD публично заявила о своем решении идти совершенно в другом направлении. Вместо все большего усложнения единого чипа, на проектирование которого инженеры ежегодно тратят астрономическое количество, как денег, так и времени, новые топ-решения AMD вообще откажутся от одночиповой компоновки. Уже привычный нам Radeon HD 3870 X2 построен по такой схеме, готовящийся к августовскому анонсу 4870 X2, известный под кодовым названием R700, также будет состоять из пары RV770. К сожалению мультичиповые технологии, что показало и наше сегодняшнее тестирование, все еще далеки от совершенства, но AMD считает целесообразным перевести одночиповые решения из топового в более низкие сегменты, где соотношение производительности на потраченные деньги намного важнее абсолютного превосходства в скорости.

Еще один аспект, который стоит учитывать оценивая GT200 — Intel Larrabee, выход которого намечен на 2009 год. Ведь именно с этим чипом, который откроет Intel дорогу на рынок графических ускорителей, будет соревноваться преемник GT200, который скорее всего не получит каких-либо серьезных архитектурных изменений, а будет просто произведен по более тонкому техпроцессу и обладать повышенными тактовыми частотами. GT200 своим появлением уже начал стирать границу между CPU и GPU, Larrabee же только поспособствует ситуации. Интересно то, что NVIDIA идет со своей привычной стороны графических ускорителей к процессорам общего назначения, Intel же — с точностью наоборот. Чей подход окажется выгоднее — объединение множества x86-совместимых ядер для обсчета графики, или унифицированная архитектура NVIDIA нам только предстоит выяснить. Пока же мы знаем только то, что Larrabee будет производиться по 45 нм техпроцессу, а уровень производительности, которому решение Intel должно будет соответствовать, заставит корпорацию выпустить свой первый чип, содержащий 1-2 млрд. транзисторов (даже Nehalem с интегрированным контроллером памяти обошелся 781 миллионом).

Выпустив GT200, NVIDIA помимо очередного скачка в производительности одночиповых карт, ступила на новую для себя землю, создав настолько мощный микропроцессор, что он может быть опасным даже для Intel. Если бы NVIDIA удалось вместе с изначальным релизом GT200 заручиться поддержкой многих разработчиков программ, чтобы те максимально использовали возможности современных GPU, Intel пришлось вступить в противостояние с NVIDIA даже до выхода Larrabee.

Однако все это касается будущего, хотя и ближайшего. Сегодня же стоит главный вопрос — а стоит ли вообще покупать одну из карт на базе GT200? И тут уже далеко не все так однозначно. Как бы ни была высока производительность GeForce GTX 280, а карта с одним чипом нового поколения почти что догоняет старую двухчиповую GX2, новинка элементарно стоит слишком дорого для той производительности, которую она показывает. Да, GTX 280 — самая мощная одночиповая карта NVIDIA, но дешевле продается карта самой же NVIDIA, GeForce 9800 GX2, которая по факту оказывается быстрее новинки. Конечно, от качества реализации поддержки SLI драйвером и конкретной игрой очень многое зависит, и могут возникнуть ситуации, когда SLI работает с огрехами, но если два года назад такие моменты возникали часто, то сейчас вероятность их появления уже стремится к нулю. Нельзя еще раз не отметить, что при 55 нм производстве с более низкой себестоимостью изготовления и конечными ценами, при повышенных частотах все могло бы быть совершенно иначе.

Даже рассматривая производительность многочиповых конфигураций (в сравнении 2-way SLI на GT200 и Quad SLI на G92) в которых пара GX2 действительно часто имеют проблемы, GeForce GTX 280 не окупает лишние средства, вложенные в такую связку.

Мнение NVIDIA таково, что в грядущих приложениях будет задействована вся мощь, которой обладает GT200, а принимая во внимание уже упомянутую программу The Way It's Meant To Be Played сложно усомниться именно в таком исходе, однако стоит ли платить такие большие деньги за плату, которая не самым лучшим образом проявляет себя в сегодняшних приложениях?

С такой позиции GeForce GTX 260 выглядит немного оправданнее. Новинка показывает уровень производительности, сравнимый с Radeon HD 3870 X2. С учетом того, что за такие деньги в модельном ряду самой NVIDIA интересных предложений нет, урезанный GT200 имеет право на существование. С другой стороны, пара 8800 GT, объединенных в SLI мало того что стоят дешевле, так еще и показывают зачастую лучший уровень производительности. Прекрасный повод докупить вторую 8800 GT и объединить их в SLI обладателям одиночной карты.

Появление более дешевых, или же быстрых альтернатив GT200 выглядит для NVIDIA опасным, так как резко снижать цены из-за высокой себестоимости чипа корпорация просто не может, а продавать себе в убыток не будет. Даже в сегменте high-end соотношение производительности и потраченной суммы значит немало, и карта с такой завышенной ценой, как GTX 280, может быть интересна только будучи безусловным чемпионом в быстродействии, чего мы с вами не наблюдаем.

Возможен и такой вариант, что с уменьшением угрозы от AMD в секторе high-end (посмотрим, на что будет способен HD 4870 X2, а на данный момент самая быстрая карта 3870 X2 далеко не лидер в скорости), NVIDIA специально установила цены на свои новые продукты таким образом, чтобы SLI системы стали, наконец, народными, а продажи материнских плат с поддержкой этой технологии пошли в гору.

|

Подождите...

Подождите...