Последствия некоторых архитектурных решений.Работа с памятью

Во время написания теоретической статьи мы множество раз задумывались о характере изменений, внесенных инженерами в Nehalem относительно Core 2. Согласно формуле, которую избрали для себя сами проектировщики, на 1% увеличения энергопотребления должно было приходиться 2% увеличения производительности. Однако вопрос в том, как правильно измерять эту самую производительность. Ведь даже добавление шины QPI в одних задачах может не сказать вообще, а в других – проявить себя в полный рост. Тоже справедливо и для нового трехканального контроллера памяти, и для реструктурированной иерархии кэша.

На самом деле больше всего вопросов вызывают именно изменения в работе с памятью, на них стоит остановиться подробнее. По опыту предыдущих тестирований несложно предугадать, например, в каких приложениях эффект от виртуальных ядер HyperThreading будет ощутим, а вот попытаться предсказать поведение Bloomfield при работе с памятью в обычных домашних приложениях – трудновато. Судите сами – с одной стороны полностью переработана кэш-память. Вместо простой, привычной и понятной структуры двухуровнего кэша перед нами механизм, работающий с тремя типами памяти разного размера и скорости. При этом крайне важный размер L2 сокращен до 256 Кб на ядро. Сможет ли это компенсировать большой, но медленный L3? Как поспособствует встроенный КП, в каких режимах он будет наиболее эффективен? Все это лишь предстоит выяснить. Чтобы не быть голословными, приведем для начала таблицу задержек кэшей различных уровней в Bloomfield и Penryn:

| |

Bloomfield |

Penryn |

| Размер L1/Задержки L1 |

64 Кб / 4 такта |

64 Кб / 3 такта |

| Размер L2/Задержки L2 |

256 Кб / 11 тактов |

6 Мб (на 2 ядра) / 15 тактов |

| Размер L3/Задержки L3 |

8 Мб / 39 тактов |

Нет |

| Задержки при работе с RAM (DDR3-1600 CAS7) |

107 тактов (33.4 нс) |

160 тактов (50.3 нс) |

Такое устройство характерно скорее для серверных CPU, Opteron давно использует схожую структуру с небольшим L2 и огромным L3. А вот самый первый Pentium 4 Extreme Edition, в котором добавили L3 в свое время не получил от этого существенной прибавки в скорости обычных приложений. Про базы данных и прочие серверные операции мы не говорим, так как перед нами все-таки процессор под торговой маркой Core, а не Xeon. Тем не менее, замерить непосредственно эффективность работы кэш-памяти проблематично. Необходимые инструменты отсутствуют, да и в любом случае неравные платформы (не забываем про месторасположение КП) даже с одинаковой памятью могут дать слишком большую погрешность измерений, сводящую полезность результатов на “нет”.

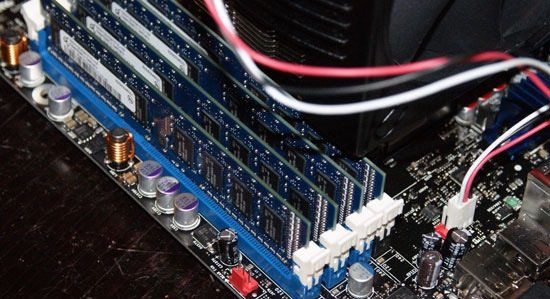

А вот отдельно скорость работы с памятью измерить можно. Только посмотрите, насколько сократились задержки КП при работе с DDR3 от переноса последнего в ядро! Более того, как уже отмечалось, каналов памяти теперь целых три, и пиковую пропускную способность в 25.6 Гб/c CPU достигает только при установке модулей на все три 64-битных контроллера. Нельзя не сказать и об особенностях работы КП Nehalem, которые будут трактоваться производителями материнских плат на свой вкус. Дело в том, что “набрать” трехканальность можно будет двумя способами. На некоторых материнских платах будет установлено 4 слота, на некоторых – 6. В случае использования конфигурации 4х слотов, первые три будут соответствовать трем каналам контроллеров в CPU, а модуль RAM, установленный в четвертый слот, будет разделять пропускную способность одного из каналов. Другими словами, если у вас установлено 4 планки по гигабайту во все 4 слота, при доступе к первым трем гигабайтам пропускная способность будет на уровне заявленных 25.6 Гб/с, а как только потребуется обратиться к четвертому гигабайту, она упадет до уровня производительности при использовании одноканального режима. В любом случае даже в таком режиме общая производительность будет больше, чем при двухканальной памяти. Выглядеть это будет так:

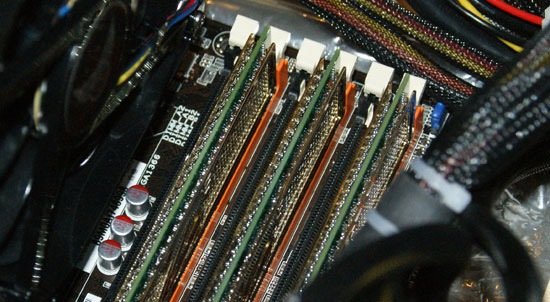

Более продвинутой является конфигурация с использованием 6 слотов для трех каналов по 2 модуля на каждый канал:

Тут все понятно и прозрачно – для трехканалности следует устанавливать либо три, либо шесть модулей.

Однако все это теория. Дополнительный третий канал памяти это, конечно, очень серьезно, однако будет ли заметен от него эффект, или же в реальных приложениях практическая ценность третей планки будет сводиться лишь к увеличенному объему? Проведя тестирование Nehalem с использованием двух и трехканального режима работы, можно сделать вывод, что это задел на будущее. Серьезный эффект от огромной пропускной способности могут получить лишь будущие серверные системы, построенные на базе CPU с числом физических ядер более шести и с несколькими такими процессорами, объединенными для параллельных вычислений. Сейчас же для домашних пользователей третий модуль является, фактически, пустой тратой денег. Хотя для получения максимальной отдачи от Nehalem и он, конечно, не лишний. Судите сами:

| |

Два канала DDR3-1066 (9-9-9-20) |

Три канала DDR3-1066 (9-9-9-20) |

| Тест памяти, Everest v. 1547 |

|

|

| Чтение |

12859 Мб/c |

13423 МБ/с |

| Запись |

12410 Мб/с |

12401 МБ/с |

| Копирование |

16474 МБ/с |

18074 МБ/с |

| Задержки |

37.2 нс |

44.2 нс |

| Cinebench R10 |

18499 |

18458 |

| Кодирование x264 HD (1ый/2ой проходы) |

83.8 FPS / 30.3 FPS |

85.3 FPS / 30.3 FPS |

| WinRar 3.80 (Сжатие папки 602 МБ) |

118 с |

117 с |

| PCMark Vantage |

7438 |

7490 |

| Vantage – Память |

6753 |

6712 |

| Vantage – ТВ и видео |

5601 |

5637 |

| Vantage – Игры |

10202 |

9849 |

| Vantage – Музыка |

5378 |

4593 |

| Vantage – Связь |

6671 |

6422 |

| Vantage – Эффективность |

7589 |

7676 |

| WinRar (Встроенный бенчмарк) |

3283 |

3306 |

| Nero Recode – Обработка 7.55 Гб |

131 с |

130 с |

| SuperPi 32M (мин:с) |

11:55 |

11:52 |

Фактически результаты многих испытаний находятся в пределе погрешности испытаний, так что огромная пропускная способность Nehalem’а, работающего с памятью в трехканальном режиме, в домашних приложениях просто не используется.

Итак, мы поняли, что высокий уровень производительности при работе с памятью достижим и без использования трех модулей памяти. Однако встает другой вопрос – какого типа памяти будет минимально достаточно для полного раскрытия потенциала Bloomfield? Ведь, скажем, многие пользователи на волне выхода первых чипсетов X38 и P35 с поддержкой DDR3 приобрели не самые производительные на текущий момент киты. Следующая таблица результатов даст ответ на этот вопрос.

| |

Три канала DDR3-1066 (9-9-9-20) |

Три канала DDR3-1333 (9-9-9-20) |

Три канала DDR3-1600 (9-9-9-24) |

| Тест памяти, Everest v. 1547 |

|

|

|

| Чтение |

13423 МБ/с |

14127 Мб/с |

17374 Мб/с |

| Запись |

12401 МБ/с |

12404 Мб/с |

14169 Мб/с |

| Задержки |

44.2 нс |

38.8 нс |

33.5 нс |

| Кодирование x264 HD (1ый/2ой проходы) |

85.3 FPS / 30.3 FPS |

86.4 FPS / 30.6 FPS |

88.1 FPS / 30.7 FPS |

| WinRar 3.80 (Сжатие папки 602 МБ) |

117 с |

111 с |

106 с |

| PCMark Vantage |

7490 |

7569 |

8102 |

| Vantage – Память |

6712 |

6809 |

6886 |

| Vantage – ТВ и видео |

5637 |

5716 |

5717 |

| Vantage – Игры |

9849 |

10570 |

11013 |

| Vantage – Музыка |

4593 |

4798 |

4896 |

| Vantage – Связь |

6422 |

6486 |

6630 |

| Vantage – Эффективность |

7676 |

7803 |

7819 |

| WinRar (Встроенный бенчмарк) |

3306 |

3520 |

3707 |

| Nero Recode – Обработка 7.55 Гб |

130 с |

127 с |

126 с |

| SuperPi 32M (мин:с) |

11:52 |

11:36 |

11:25 |

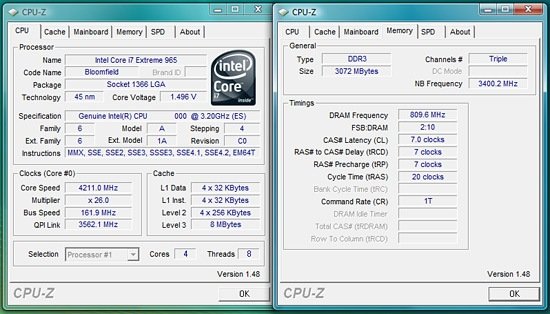

Сделаем небольшую оговорку для внимательных читателей – частота памяти 1600 МГц была получена на i7-965 EE путем установки множителя Uncore в положение x24.0, и, соответственно, памяти в x12.0,то есть, фактически, это уже нештатный режим работы и небольшой разгон.

Как и следовало ожидать, бескомпромиссную производительность показывает кит из трех модулей быстрой DDR3-1600. Однако нельзя не заметить, что разница между DDR3-1066 и 1600 на сходных таймингах (а это, между прочим, полуторакратная разница в пропускной способности) не очень сильно влияет на результаты. Это только подтверждает выводы предыдущего абзаца – используя в повседневной работе стандартные неспециализированные приложения, не стоит гнаться за максимальной производительностью подсистемы памяти Core i7. Разница в цене между самым производительным и средним вариантом (не стоит уходить в крайности и оставлять одноканальную память) будет бросаться в глаза намного больше, чем разница в скорости работы реальных приложений.

Источник:

www.tomshardware.com

www.anandtech.com

[N5-Последствия некоторых архитектурных решений. Новый вариант реализации HyperThreading]

Еще одним важным нововведением в Nehalem стала реализация HyperThreading. В свое время, проектируя Core 2, инженеры отказались от данной технологии, так как софт был еще не оптимизирован даже под два реальных ядра, а уж о реальной пользе двух дополнительных виртуальных ядер можно было и не мечтать. Сейчас по мнению Intel ситуация иная, и самое время реализовать HT для обновленной архитектуры.

Вспоминая первый вариант HyperThreading на Pentium 4, можно выделить два основных минуса: серьезное возрастание и без того немалого энергопотребления при активации технологии, и снижение производительности CPU в случае, если программа не задействует виртуальное ядро. С учетом того, что сегодня о соотношении производительности на Ватт разработчики не забывают, но и реальных ядер без того много, особенно интересно, как поведет себя новая версия HT. Скажем, что для получения полной картины мы провели достаточное количество тестов, однако приводить все результаты не имеет смысла. Технология работает хорошо, хотя и не идеально. Можно выделить 3 результата, соответственно отражающих максимальный эффект, среднее положение вещей, и наихудший вариант.

| Core i7-965 |

POV-Ray 3.7 Beta 29 |

Race Driver: GRID |

Cinebench R10 1 Поток |

| С HyperThreading |

4202 PPS |

233.7 Вт |

102.9 FPS |

302 Вт |

4452 CBMarks |

169.1 Вт |

| Без HyperThreading |

3239 PPS |

207 Вт |

103 FPS |

300.7 Вт |

4671 CBMarks |

159.5 Вт |

Видно, что в приложениях, хорошо оптимизированных под многоядерность, эффект от включения HT может достигать 30%, что сопровождается 12% ростом энергопотребления (как раз вспоминается правило 1:2). При этом, в общем и целом, большинство приложений не получают никакого выигрыша от HT, так как не способны задействовать и 4 физических ядра. В худшем случае производительность немного падает, однако при этом хотя бы не возрастает энергопотребление, как было в случае с Pentium 4, да и случаи такие редки. Таким образом, выключать HT смысла нет – вы как минимум не проиграете в производительности, а, можете и существенно выиграть. Причем чем “тяжелее” приложения, запускаемые на Nehalem, тем выигрыш будет больше.

Источник:

www.tomshardware.com

www.anandtech.com

[N6-Последствия некоторых архитектурных решений. Новые технологии контроля энергопотребления Core i7]

На особое место хочется поставить заслуги инженеров Intel, сумевших сделать новый процессор энергетически эффективным и столь же экономичным, как его предшественника, несмотря на возросшую сложность дизайна и добавление многочисленных усовершенствований и улучшений. Стоит повториться, что первый коммерческий степпинг не идеален. Например, Core 2 Quad Q9450, работающий на частоте 2.66 ГГц, имеет TDP на уровне 95 Вт, тогда как i7-920 на той же частоте требует 130 Вт. Обусловлено это тем, что Intel приходиться перестраховывается. Пока производство не отлажено у корпорации нет возможности тестировать CPU на пониженных напряжениях, поэтому почти для всех Core i7 сейчас Vcore устанавливается не ниже отметки 1.137 В. Q9450, при этом, штатно может питаться и 0.85 В (конечно, все зависит от удачности конкретного экземпляра процессора, но официально заявленное минимальное значение такого). Это отнюдь не значит, что i7-920 не может работать, например, на 1.0 В, но такие пониженные напряжения надо подбирать самостоятельно, не забывая тестировать стабильность. Новые степпинги однозначно принесут понижение напряжения и TDP, но, как показало тестирование, даже сейчас дела обстоят очень хорошо.

Для сравнения мы решили воспользоваться самыми горячими топовыми процессорами новой и предыдущей линеек – Core i7-965 Extreme Edition и Core 2 Extreme QX9770 соответственно. Они имеют схожий TDP (130 Вт для i7 и 136 Вт для QX) и работают на одинаковой частоте 3.2 ГГц. Для получения более точных результатов мы использовали несколько семплов процессоров, усредняя в таблице полученные данные:

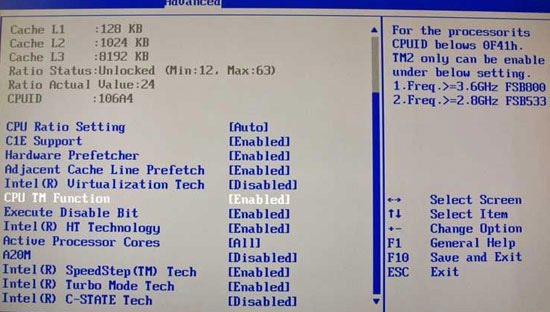

Перед представление результатов очередное важное замечание – при сборке системы на базе Core i7 обязательно проверяйте установки BIOS материнских плат в разделе Power Management или аналогичных. Все энергосберегающие технологии должны быть включены, иначе повысится потребление в состояние покоя и т.п. В нашем случае, например, почему то оказалась выключенной опция QPI Power Management, которая недвусмысленно влияла на результаты, естественно в худшую сторону. После ее активации верная картина получилась такой:

| |

Core 2 Extreme QX9770 |

Core i7-965 EE |

| В состоянии покоя |

138.7 Вт |

105.5 Вт |

| POV-Ray |

230.7 Вт |

240.4 Вт |

| Cinebench (1 Поток) |

194.3 Вт |

168.3 Вт |

| Cinebench (Max Потоков) |

227.6 Вт |

230.7 Вт |

| 3dsmax 9 SPECapc Тест CPU |

220.1 Вт |

209.4 Вт |

| Кодирование x264 HD |

230.3 Вт |

196.2 Вт |

| DivX 6.8.3 |

221.7 Вт |

202.1 Вт |

| Windows Media Encoder |

249 Вт |

201.2 Вт |

| Age Of Conan |

306.2 Вт |

267.3 Вт |

| Race Driver: GRID |

348.8 Вт |

302 Вт |

| Crysis |

293.6 Вт |

248.5 Вт |

| FarCry 2 |

324.2 Вт |

271.9 Вт |

| Fallout 3 |

303.2 Вт |

225 Вт |

Крайне впечатляющие результаты! Особенно если принимать во внимание, что контроллер памяти теперь находится под крышкой процессора, и что активация HT также вносит свою лепту в энергопотребление. Особенно заметен выигрыш в состоянии покоя. В играх также разница очень и очень существенна. Более того, посмотрите на сами результаты тестов, во время которых были сделаны замеры энергопотребления:

| |

Core 2 Extreme QX9770 |

Core i7-965 EE |

| POV-Ray |

2641 PPS |

4202 PPS |

| Cinebench (1 Поток) |

3937 CBMarks |

4475 CBMarks |

| Cinebench (Max Потоков) |

14065 CBMarks |

18810 CBMarks |

| 3dsmax 9 SPECapc Тест CPU |

13.1 |

17.6 |

| Кодирование x264 HD |

73.2 FPS |

85.8 FPS |

| DivX 6.8.3 |

42.4 с |

32.8 с |

| Windows Media Encoder |

29 с |

24 с |

| Age Of Conan |

107.9 FPS |

123 FPS |

| Race Driver: GRID |

103 FPS |

102.9 FPS |

| Crysis |

41.7 FPS |

40.5 FPS |

| FarCry 2 |

102.6 FPS |

115.1 FPS |

| Fallout 3 |

77.2 FPS |

83.2 FPS |

Поразительно, но почти во всех тестах Core i7 взял верх над своим предшественником, потребляя при этом меньше энергии. Выходит, что, несмотря на одинаковый техпроцесс, Nehalem может быть намного экономичнее Penryn. Особенно интересным выглядит факт превосходства нового CPU под высокой нагрузкой на все вычислительные блоки – ведь если победу в состоянии покоя легко можно объяснить новомодной технологией энергетических шлюзов, полностью отключающих питание ядер, то в остальных сложных режимах спасибо говорить надо однозначно интеллектуальному блоку Power Control Unit.

Источник:

www.tomshardware.com

www.anandtech.com

[N7-Последствия некоторых архитектурных решений. Функционирование турбо-режима и оверклокинг]

Так сложилось, что последние семейства процессоров Intel отлично разгоняются. Видимо, сказывается высокая степень отлаженности 65 и 45 нм техпроцессов в паре с удачной компоновкой самих CPU и постоянной работой над улучшением тепло-электрических характеристик в виде постоянно обновляющихся степпингов. 4 ГГц на простом воздушном охлаждении для процессоров Penryn – привычная частота, покоряющаяся подавляющему большинству CPU без каких-либо проблем. Однако штатные частоты CPU в первую очередь по маркетинговым причинам ограничены. Какой смысл выпускать, скажем, 3.8 ГГц Core 2 Duo, когда и на трех гигагерцах конкуренты из стана AMD повержены, а конкуренция идет не на поле производительности, а скорее ценообразования.

Тем не менее, процент пользователей, о разгоне осведомленных, крайне невелик, и разномастные CPU от Pentium Dual Core E2140 до Core 2 Duo E8600 трудятся на штатных частотах, никак не задействуя свои резервы. Справедливо решив, что незачем добру пропадать, в Intel решили создать встроенную в CPU технологию авто-разгона. Впервые она была представлена в мобильной версии Penryn, а в Nehalem получила свое дальнейшее развитие. Мы уже рассказывали о принципе ее работы, однако стоит кратко повторить суть, так как с этим связаны некоторые возникшие недоразумения при ручном разгоне. Итак, у каждого CPU есть заводской TDP. Сейчас, напомним, для всех Bloomfield он равен 130 Вт. Блок PCU постоянно мониторит потребляемую энергию, напряжения, температуру процессора и другие параметры. Если в данный конкретный момент температура достаточно низкая, а TDP не выходит за установленные рамки, множитель может быть увеличен либо на единичку, либо на двойку. Это может сопровождаться отключением неиспользованных ядер и прочими действиями для поддержания приемлемого тепловыделения.

При этом если процессор вдруг начинает перегреваться, то мгновенно возвращаются штатные, или даже ослабленные параметры для предотвращения угрозы перегрева. Кстати говоря, в покое SpeedStep скидывает множитель до x12.0, что соответствует частоте 1.6 ГГц. Ясно, что Turbo-Mode с его дополнительные 133 или 266 МГц особой погоды не сделают, но и они будут приятным бонусом для неискушенных пользователей. Чтобы результаты основного тестирования были “честными” и их можно было бы с точностью воспроизвести, в основном тестировании TM мы отключили, однако при включении данной технологии преимущество может оказаться приблизительно таким:

| |

POV-Ray |

3dsmax 9 SPECapc |

x264 HD (1ый/2ой проходы) |

iTunes, конвертация WAV в MP3 |

iTunes, конвертация WAV в AAC |

| i7-965 EE с TM |

4017 PPS |

17.1 |

82.7 FPS / 30.4 FPS |

27.1 с |

34.1 с |

| i7-965 EE без TM |

4202 PPS |

17.6 |

85.8 FPS / 31.6 FPS |

26.4 с |

32.8 с |

| Преимущество |

4.6 % |

2.8 % |

4.6 % |

4.1 % |

3.8 % |

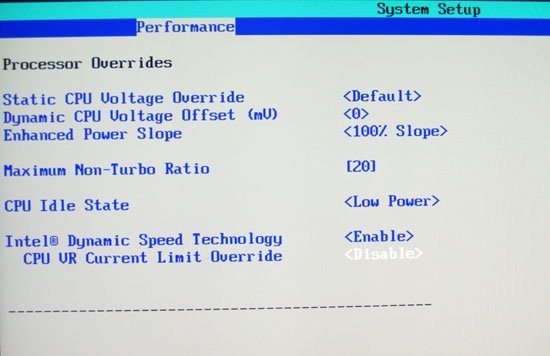

Много это или мало – судить сложно, наверное, лучше, чем ничего. В любом случае, автоматический разгон никогда не поднимал производительность системы существенно. А вот с ручным разгоном Nehalem изначально возникли сложности. Дело в том, что появилась информация, согласно которой блок PCU намертво блокировал любые попытки разгона при превышении процессором установленных границ TDP. Естественно, при любом мало-мальски значимом повышении частот энергопотребление и тепловыделение существенно превышает заводское значение TDP. Отключить эту функцию было возможно только на “экстремальном” i7-965. Таким образом, об оверклокинге фактически можно было забыть. Началось шаманство с целью выяснения, как повысить значения множителя при переходе CPU в Turbo Mode и прочие неочевидные действия. Однако, в конце концов, оказалось, что невозможность отключения аппаратной защиты от превышения TDP – не более чем недоработка первых версий BIOS, которыми снабжались самые популярные платы с LGA1366 – ASUS Rampage II Extreme и Intel DX58SO. После обновления появляется такая опция:

А в версии BIOS для ASUS:

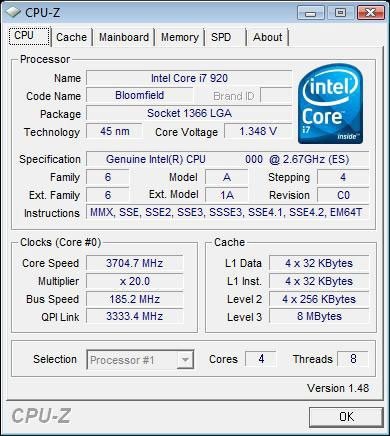

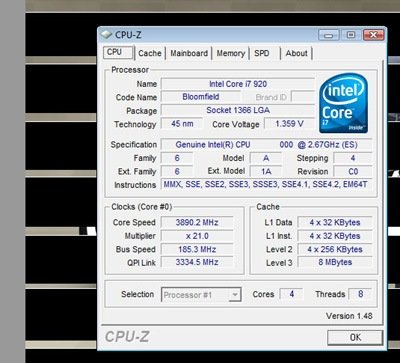

Итак, отключив данную не особо полезную функцию, можно преступать к разгону. Фактически, технология особо не отличается от привычной нам по Core 2, большой плюс состоит в том, что отныне частота памяти напрямую не привязана к FSB. Так как множители на неэкстремальных процессорах залочены на повышение, приходится поднимать частоту тактового генератора. Для того чтобы не затрагивать другие частоты, зависящие от него (например, шины QPI и Uncore), соответственно следует снижать их коэффициенты умножения. Без повышения напряжения на воздушном охлаждении наш младший CPU Core i7-920 смог разогнаться до 3.3 ГГц (тактовый генератор работал на 165 МГц). С небольшим повышением Vcore до 1.37 V стала достижима частота ядра в 3.7 ГГц.

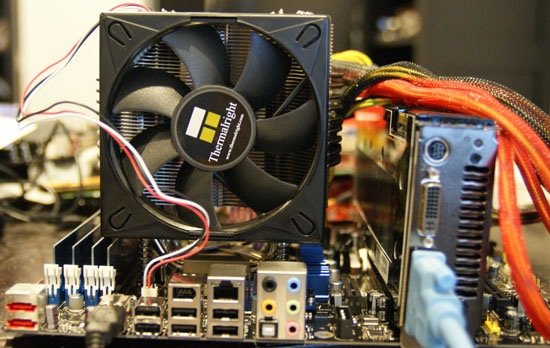

Процессор охлаждался кулером Thermalright Ultra 120 Extreme, стабильно проходил трехчасовое тестирование OCCT, а также Linpack. Повышение частоты Bclock сопровождалось крахом системы. При этом повышение напряжения еще на одну ступень сопровождалось серьезным ростом тепловыделения, а убивать процессор в наши планы не входило. Очевидно, что это не предел, однако необходимы более серьезные системы охлаждения для выяснения потенциала CPU при повышении напряжения.

Однако оказалось, что можно сделать еще кое-что, для того, чтобы немного увеличить частоту CPU не поднимая напряжения и частоты тактового генератора. Оказалось, что турбо-режим исправно работает при отключенной функции контроля TDP, и даже с разогнанным CPU! Поэтому под нагрузкой заблокированный множитель x20.0 поднимался до x21.0, и частота составляла 3.89 ГГц.

Процессор был все также стабилен и функционировал на высокой частоте, почти в полтора раза превышающей номинал, при допустимых температурах (Intel заявляет о критическом пороге срабатывания троттлинга 100 градусов, при наших экспериментах по разгону температура под нагрузкой ни разу не превышала 80 градусов).

Так что, оказалось, разгонять Core i7 не так и сложно, а частотный потенциал процессора ничуть не ухудшился по сравнению с Core 2 Quad (Wolfdale не работают на столь же высоких частотах, как однокристальные двухядерные Penryn). Думается, что в среднем для CPU степпинга C0 будут покоряться частоты в 3.8-4.0 ГГц, а в дальнейшем с переходом на новые ревизии частоты только возрастут вместе с понижением напряжений и TDP.

Что касается экстремального i7-965 EE, возможность вручную поднять множитель без повышения частоты системного генератора способствовала разгону до 4 ГГц при том же напряжении 1.37 В, с которым i7-920 работал на 3.7 ГГц. 4.2 ГГц покорились при напряжении 1.5 В:

С использованием системы водяного охлаждения CoolIT FreeZone Elite, CPU заработал и на 4.5 ГГц при 1.55 В.

Источник:

www.tomshardware.com

www.anandtech.com

[N8-Intel X58 как неотъемлемая составляющая новой платформы]

Так как новый процессор Core i7 является полностью новой моделью CPU в конструктивном и компоновочном плане, для него нужен и новый чипсет. Основная причина, по которой старые северные мосты вроде P45 или X48 с Core i7 несовместимы – интеграция контроллера памяти в сам процессор. Так как Intel традиционно является лидером в производстве чипсетов для своих процессоров, и в этот раз синхронно с релизом Core i7 корпорация представила новый набор логики X58. На сегодня он является единственным чипсетом, который работает с Core i7. Его блочная диаграмма в традиционных цветах Intel выглядит так:

Если говорить грубо, X58 (кодовое название – Tylersburg) превратился из северного моста в контроллер PCI-Express. С этим связаны некоторые интересные особенности, о которых мы поговорим абзацем ниже. В качестве южного моста выступает уже знакомый нам ICH10/R. Об уже стандартных возможностях вроде 12 портов USB 2.0, 6 SATA2 или HDA кодека говорить смысла нет. Скорее всего, Intel не стали трогать южный мост потому, что в следующем поколении чипсетов (например, P55) дизайн системной логики станет моночиповым, то есть не будет отдельно северного и южных мостов. Такая схема уже давно применялась NVIDIA (еще в nForce 3 для K8 чипсет состоял из одной микросхемы), это упрощает разводку материнской платы, и, следовательно, в последующем удобство сборки.

Но сейчас мы имеем, что имеем, а северный мост таки заслуживает внимания. Дело в том, что впервые на чипсете Intel NVIDIA разрешила реализовать поддержку SLI. Ранее все чипсеты компании п |

Подождите...

Подождите...