В данной статье мы проанализируем рост пропускной способности оперативной памяти в серверных платформах последнего десятилетия, в том числе в пересчете на ядро CPU.

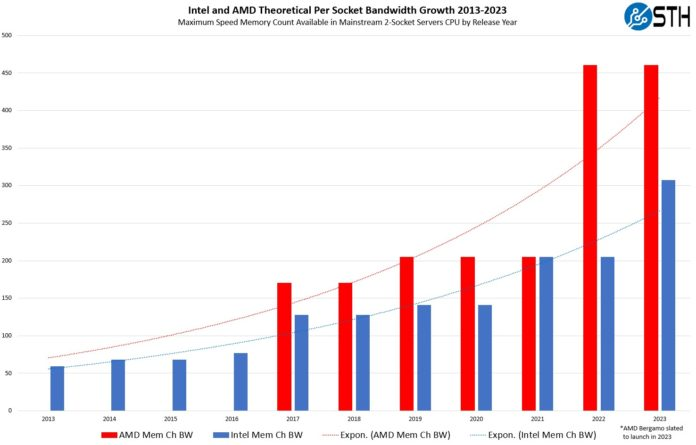

Сначала давайте посмотрим на эволюцию пропускной способности каналов памяти сокета CPU. Показанные на рисунке ниже значения теоретической пропускной способности определяются как число каналов памяти сокета, умноженное на пропускную способность DIMM-модуля памяти.

Видно, что пропускная способность памяти на каждом сокете получала меньшие приращения везде, где имела место смена поколений памяти в серверах (например, переход от DDR4-2133 к DDR4-3200). Более выраженный рост наблюдается там, где помимо обновления самой памяти увеличивалось также число каналов. Например, в 2017 году, когда в Intel перешли с 4-канальной конфигурации DDR4 на 6-канальную, и затем в 2021 году с переходом от шести к восьми каналам. Когда мы обсуждаем актуальность DDR5 для серверов, можно здесь же в качестве иллюстрации отметить грандиозный скачок у AMD в 2022 году, когда они перешли с восьми каналов на двенадцать и одновременно – с DDR4 на DDR5. Для сравнения, у Intel мы видим просто заметный прирост при переходе с восьми каналов DDR4-3200 на те же восемь каналов DDR5-4800.

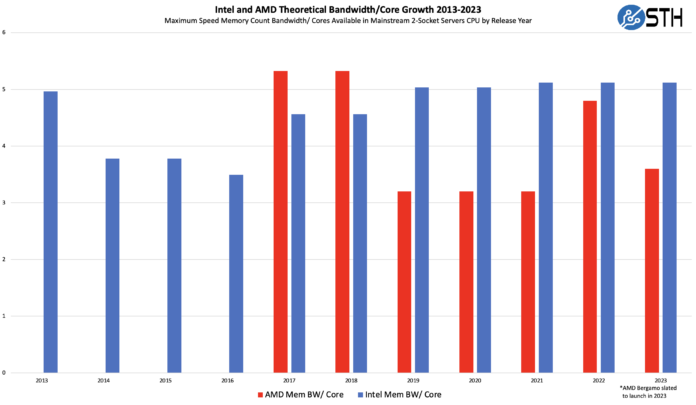

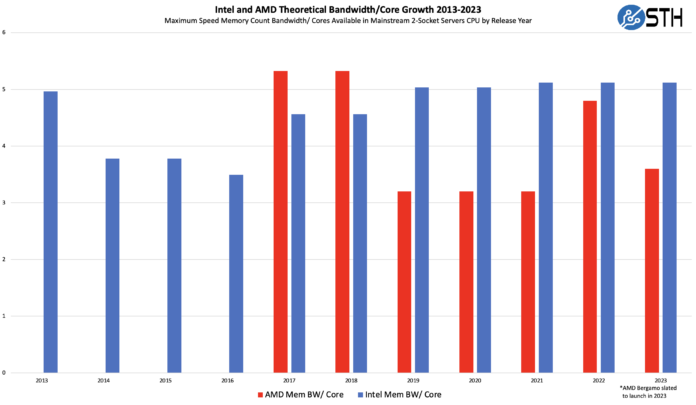

Тренд выглядит оптимистично, но нужно принять во внимание еще и количество ядер процессора. Увеличение числа ядер означает, что подсистема памяти теперь обслуживает больший их массив, и, соответственно, ее пропускная способность распределяется на большее их число. Если мы возьмем приведенные выше показатели и соотнесем их с максимальным на тот момент числом ядер, которое могло приходиться на соответствующий сокет, тренд трансформируется следующим образом:

Intel в целом сохраняет тенденцию к увеличению пропускной способности памяти в пересчете на каждое ядро CPU; при переходе от 2-го поколения Intel Xeon Scalable “Cascade Lake” к третьему – “Ice Lake” – максимальное число ядер на сокет выросло с 28 до 40, т.е. примерно на 43%. Одновременно с этим в Intel увеличили число каналов памяти на 33% и далее перешли с памяти DDR4-2933 на DDR4-3200, результатом чего стало примерно 9%-ное увеличение производительности на канал. Эта комбинация позволила сбалансировать производительность. Аналогично, переход от Ice Lake к 4-му поколению Intel Xeon Scalable “Sapphire Rapids” с увеличением в полтора раза как числа ядер (с 40 до 60), так и теоретической пропускной способности модуля DIMM (DDR5-4800 против DDR4-3200) на диаграмме характеризуется плоским плато, аппроксимирующим показатели за соответствующие годы.

У AMD все не так просто. В AMD при переходе от Naples к Rome удвоили число ядер, но число каналов памяти осталось тем же при увеличении скорости самой памяти. В последнем поколении AMD EPYC 9004 “Genoa” число ядер выросло только в полтора раза, но существенно увеличилась пропускная способность подсистемы памяти – за счет как увеличения числа каналов, так и скорости памяти. В результате Genoa выбивается из тренда, задаваемого поколениями Rome и Milan. В ближайшее время ожидается выход поколения Bergamo, в котором будет 128 ядер CPU, урезанный кэш, но такой же сокет (SP5), как у Genoa. Мы здесь брали в расчет пропускную способность DDR5-4800, но есть шанс, что в серии AMD Bergamo будут использоваться более быстрые контроллеры памяти.

И еще раз обращаем ваше внимание на то, что эти диаграммы относятся к топовым SKU. Если мы возьмем 64-ядерные опции AMD поколений Naples и Genoa или 16-ядерные Intel E5-2600 V3 и Sapphire Rapids, то разница в пропускной способности памяти в пересчете на ядро между поколениями будет очень значительной.

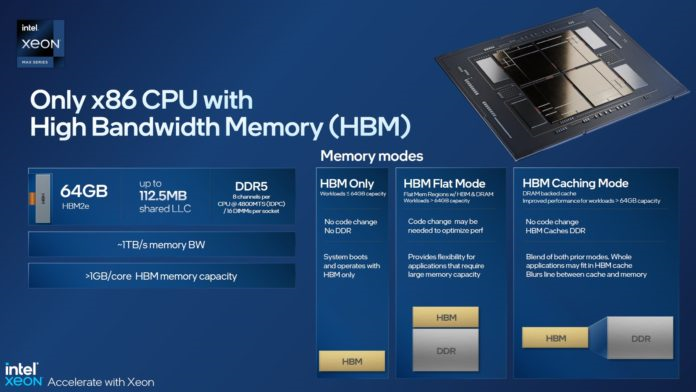

Со своей стороны Intel предлагает новую серию Xeon Max со встроенной памятью HBM, где меньший объем компенсируется большей пропускной способностью памяти, примыкающей к ядрам CPU. Такие компании, как NVIDIA (Grace), AMD (MI300) и Apple (линейки M1/ M2) к концу 2023 года также планируют внедрить в указанных сериях интегральные компоновки памяти с CPU/ GPU.

Этот тип архитектуры разработан специально в целях увеличения пропускной способности подсистемы памяти, которая в других аспектах не разрастается.

Резюме

Итак, мы рассмотрели эволюцию пропускной способности подсистемы памяти на разных конфигурациях сокета и с учетом числа ядер процессора. Конечно, есть еще один важный компонент – производительность. Мы оценивали пропускную способность, но производительность памяти в пересчете на ядро за последнее десятилетие выросла в 2.5-3 раза. Мы поговорим об этом более подробно в обзоре DDR5.

Аналогичные диаграммы строили еще в 1970-х годах. Поскольку серверы часто покупают как минимум на одно поколение старше текущего новейшего поколения, мы полагаем, что поколение Ivy Bridge-EP/ Haswell-EP (Intel Xeon E5-2600 V2/V3) – это крайнее поколение, подлежащее в ближайшее время массовому апгрейду (или только что замененное на более новое). Многие производители серверов говорят, что платформы Intel поколения Xeon E5-2600 V4 и 1-го поколения Xeon Scalable в настоящий момент являются одними из самых популярных вариантов апгрейда. Десятилетие – это просто наиболее показательный период для всего эксплуатируемого оборудования, охватывающий как серии, недавно снятые с эксплуатации, так и серии, которые будут представлять ближайший цикл модернизации.

Мы надеемся, что приведенные в этой статье диаграммы будут полезны с точки зрения оценки текущих тенденций в отрасли и принятия решений по апгрейду серверных платформ.

Подождите...

Подождите...