Модель AIC HA401-TU претендует на звание одного из самых уникальных серверов хранения данных этого года. Двухнодовые системы мы видели и раньше. Однако этот СХД имеет два важных отличия: во-первых, это четырехъюнитовый (4U) сервер; во-вторых, его системная конфигурация предназначена для хранения данных, к которым предполагается быстрый доступ через интерфейс SAS, причем доступ к установленным SAS SSD организован на обеих нодах. Такое решение выглядит очень интересным и привлекательным, и в данном обзоре мы рассмотрим его более подробно.

СХД AIC HA401-TU: внешний вид корпуса

На передней панели корпуса 4U мы видим 24 отсека для накопителей 3.5″. Эти отсеки поддерживают не только SATA, но и SAS. Отличие от других аналогичных корпусов заключается в том, что здесь SAS имеет приоритет.

СХД AIC HA401-TU: вид спереди.

Сам корпус не очень глубокий – 27.7 дюймов (705 мм). Хотя эта глубина отнюдь не относится к разряду малых: корпус вписывается в большинство стоек. Кроме того, поскольку блоки питания и ноды задвигаются в корпус сзади, а диски – спереди, единственным основанием для снятия уже установленного корпуса сервера может быть только обслуживание общей объединительной платы (midplane).

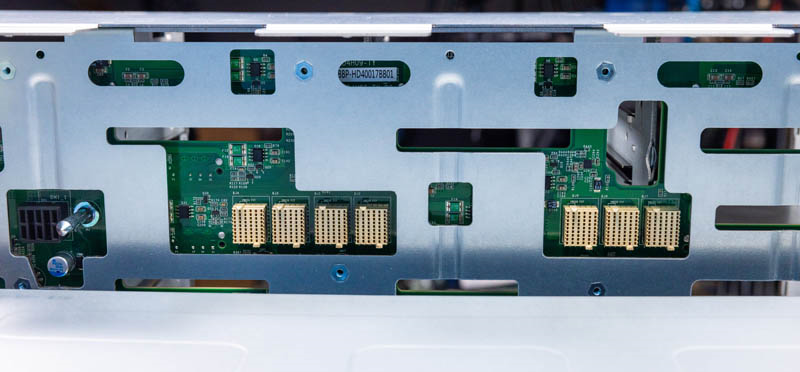

СХД AIC HA401-TU: объединительная плата накопителей (backplane).

Мы тестировали в этом сервере различные дисковые накопители, но вы можете использовать SATA SSD 2.5″, например, Micron 5400 Pro. И тем не менее, конкретно для этой системы мы рекомендуем главным образом диски SAS3.

СХД AIC HA401-TU: диск 2.5″ в салазках 3.5″.

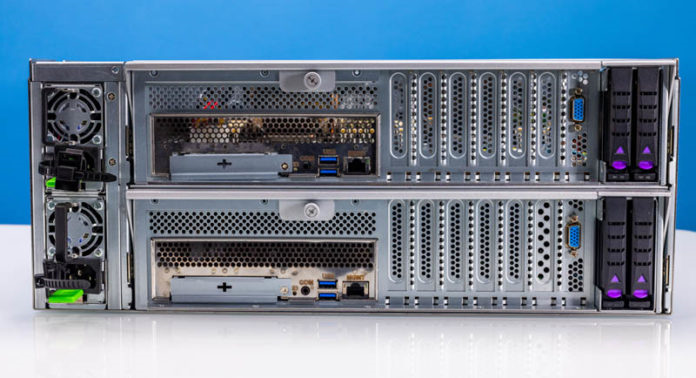

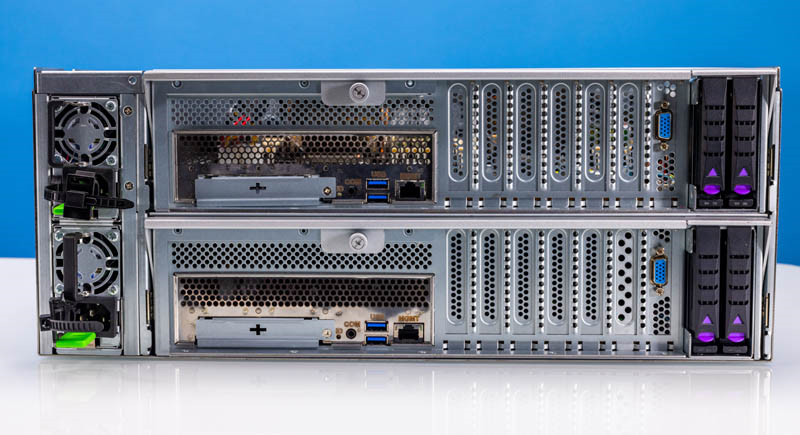

На задней панели корпуса сервера мы видим два набора компонентов: верхний и нижний блоки питания и верхнюю и нижнюю управляющие ноды.

СХД AIC HA401-TU: вид сзади (БП и ноды).

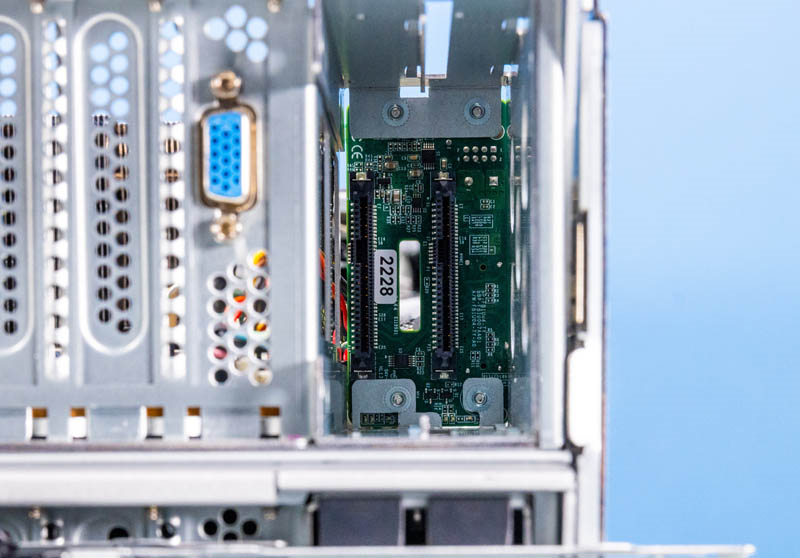

На каждой из двух нод есть крышка для слота OCP NIC 3.0, который мы увидим внутри корпуса. Снаружи на главной панели I/O – только COM-порт, два порта USB 3 и порт внешнего управления (out-of-band management). Порт VGA расположен левее задних отсеков SSD 2.5″. В следующем разделе мы рассмотрим ноды более детально.

В качестве блоков питания здесь используются устройства класса 80 Plus Platinum мощностью 1.2 кВт. Поскольку это платформа Intel Xeon Scalable 3-го поколения, а не 4-го, мы все-таки располагаем солидным потенциалом производительности для накопителей и при этом можем обеспечить его с меньшими энергетическими затратами.

СХД AIC HA401-TU: блок питания.

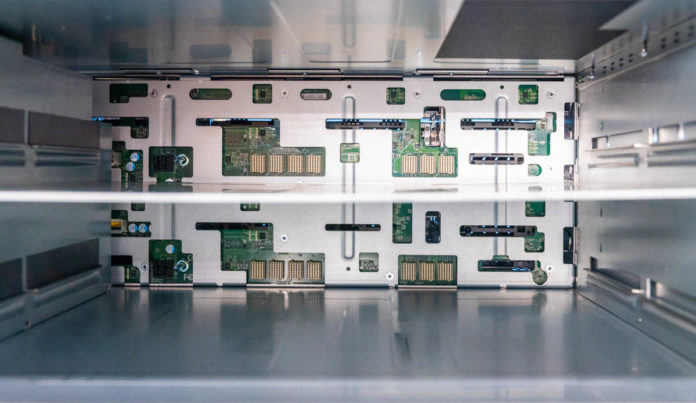

Заглянув внутрь корпуса, мы видим двустороннюю объединительную плату (midplane) с высокой плотностью коннекторов питания и передачи данных взамен кабельных коннекторов. Вместо того, чтобы использовать плату типа backplane с SAS-удлинителем Broadcom с многочисленными кабельными коннекторами, AIC применяет здесь другое решение, обеспечивающее большую простоту при замене нод без возни с кучей кабелей.

СХД AIC HA401-TU: коннекторы с прессовой посадкой.

Эта возможность имеет важное значение. Организация объединительной платы по такому принципу гарантирует, что даже в случае необходимости технического обслуживания управляющего модуля или накопителя корпус сервера с остальным оборудованием может оставаться в стойке и продолжать работу с данными. Для файлового сервера с быстрым доступом к данным наличие резервных контроллеров, дисков и блоков питания в корпусе, который при проведении обслуживания не придется снимать целиком, исключительно важно в аспекте долгосрочного использования.

СХД AIC HA401-TU: внутренние подключения нод.

Теперь давайте рассмотрим поближе решение AIC в части организации серверных нод.

Сервер хранения данных AIC HA401-TU: ноды

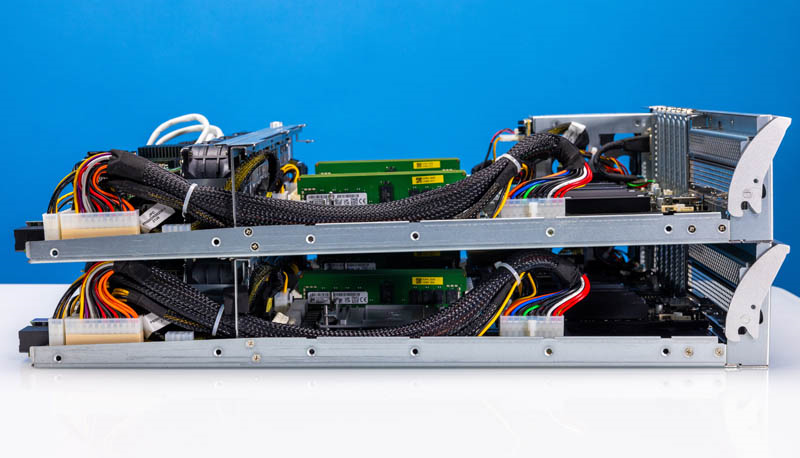

На рисунке ниже показана конструкция стека из двух нод (вид сбоку), извлеченная из корпуса. Видно, что ноды идентичны.

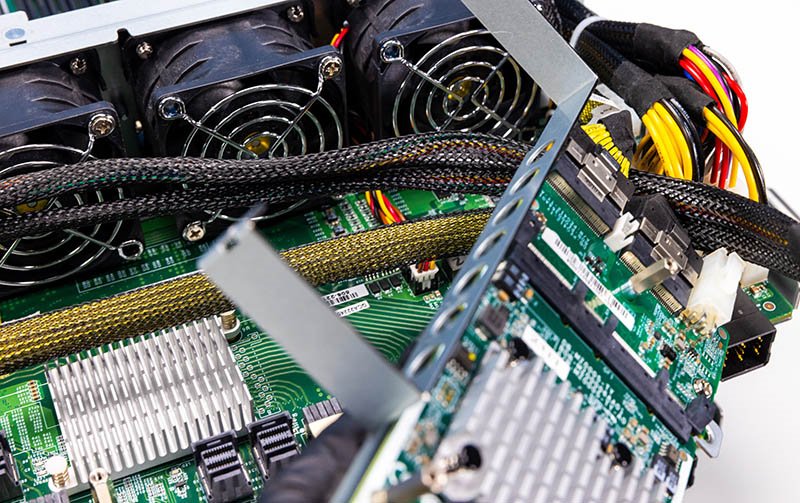

Каждая нода содержит два процессора, память, сетевые карты, загрузочные диски и цепи питания. Отличительной особенностью этой конструкции является то, что вентиляторы устанавливаются на салазках, а не являются частью корпуса. Это значит, что для обслуживания вентиляторов достаточно выдвинуть из корпуса одну ноду, а вторую вместе с накопителями оставить в стойке.

Ниже представлен вид нод сзади. Как вы сами можете видеть, здесь множество коннекторов и кабелей, в том числе кабели Ethernet.

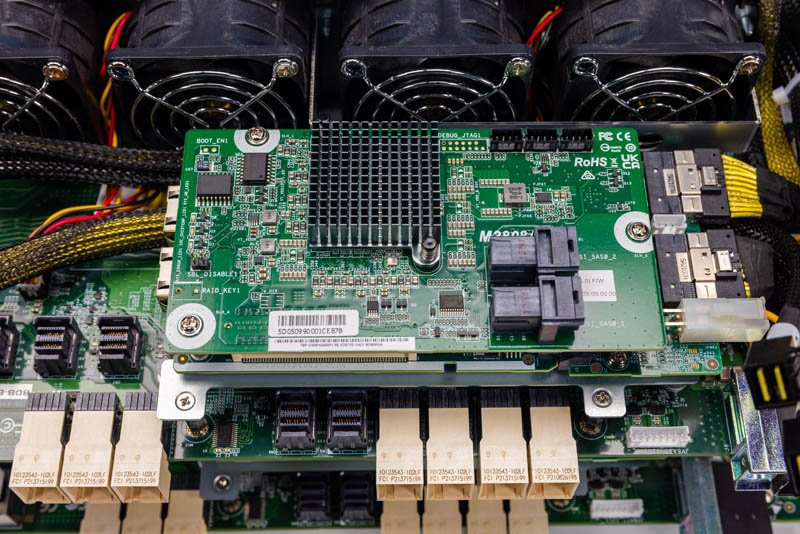

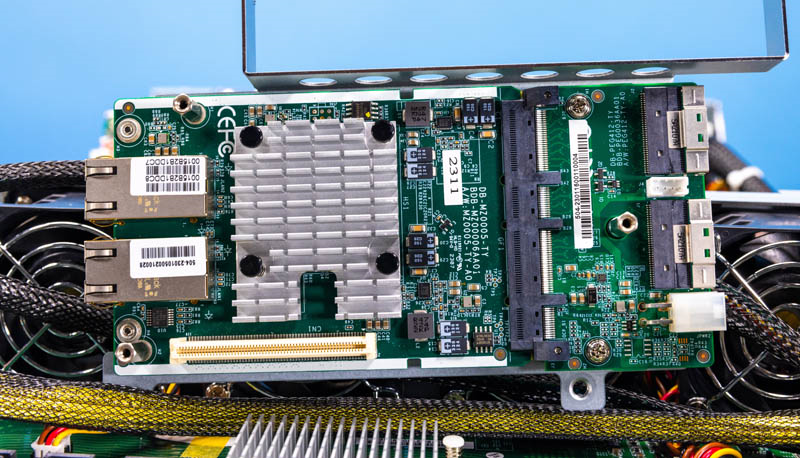

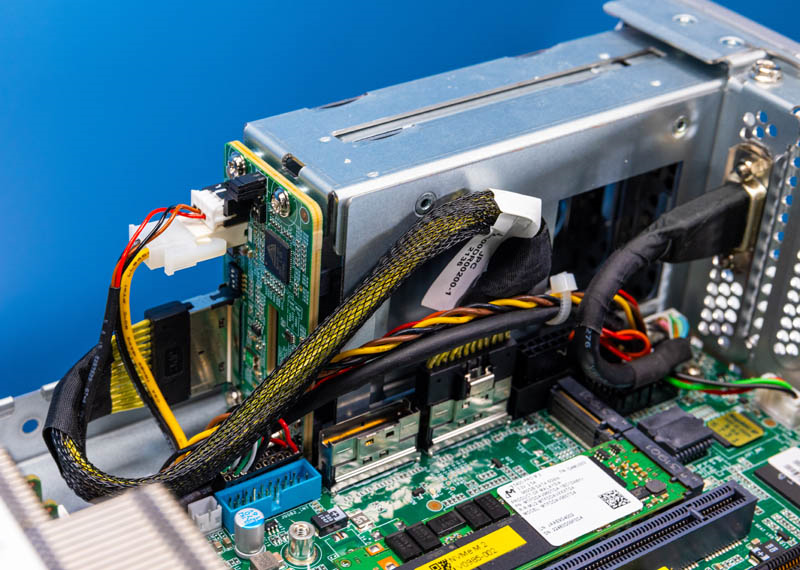

Вид сверху показывает нам контроллер Broadcom M3808AK поколения LSI SAS3808 контроллеров PCIe Gen4 x8 SAS3.

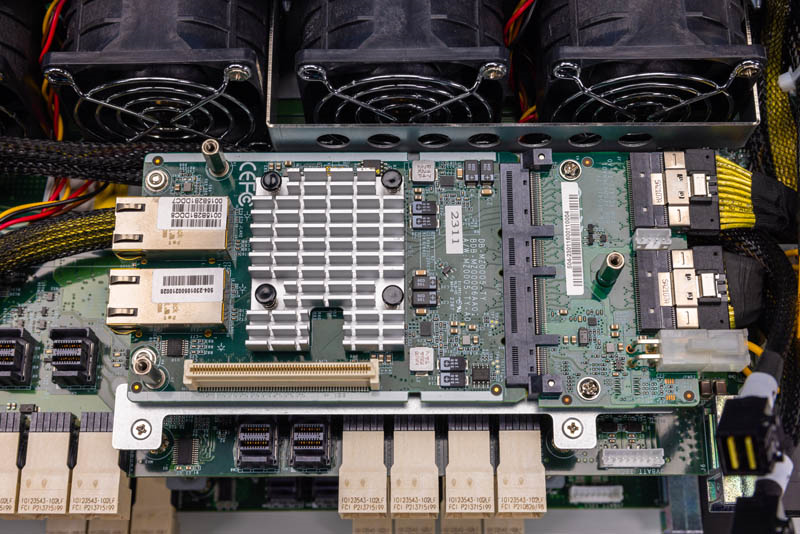

Он подключается к одной из самых интересных и уникальных карт, какие только можно увидеть. Справа мы имеем два 8-линейных коннектора PCIe, которые подключаются к плате со слотом OCP NIC 3.0. К этому слоту подключен двухпортовый контроллер 10Gbase-T. Этот двухпортовый контроллер OCP NIC 3.0 имеет мезонинное крепление для контроллера SAS3, который сажается сверху.

Такая организация подключения 10GbE является частью концепции быстрого доступа (HA), но это совершенно потрясающая карта. На наш взгляд, это лучшее локальное решение в этом сервере.

Эти три этажа располагаются поверх платы SAS-удлинителя Broadcom.

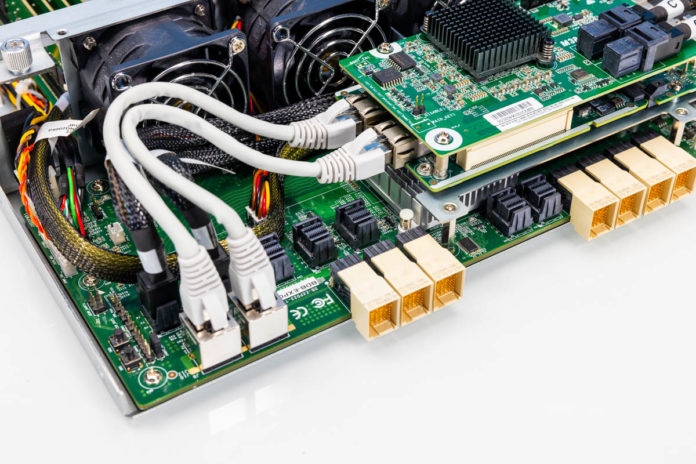

Поскольку в этом стеке у нас только восемь портов, нам также нужен SAS-удлинитель Broadcom 35X48 на каждой ноде, чтобы перейти от восьми портов контроллера к 24 дисковым накопителям на бэкплейне. На PCB мы видим большее число коннекторов SFF-8643 для удлинителя SAS.

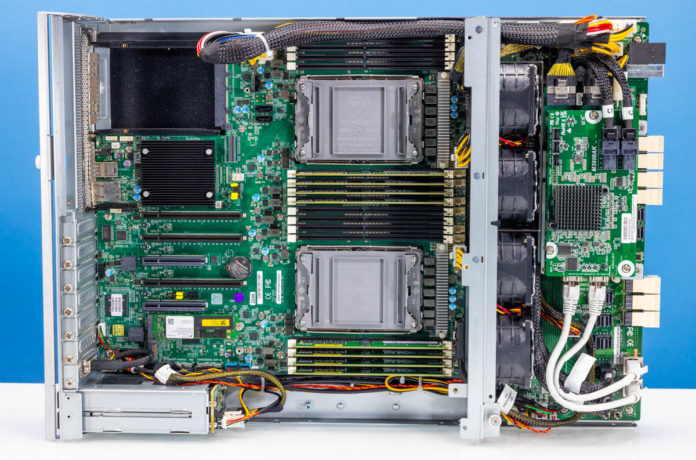

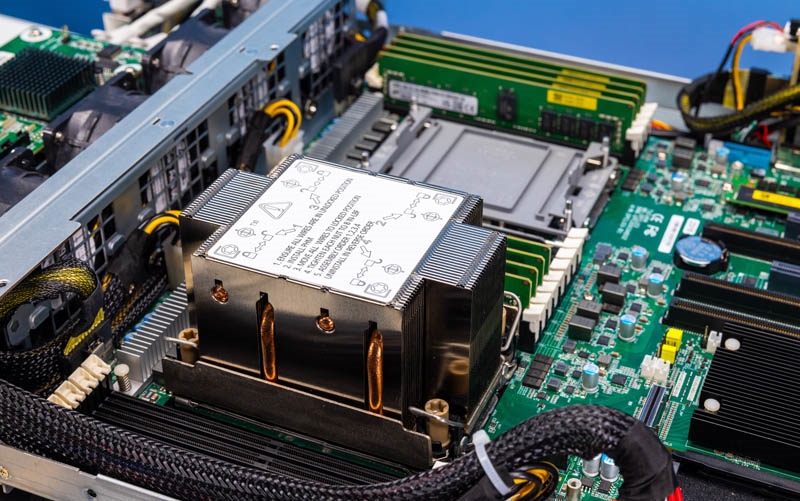

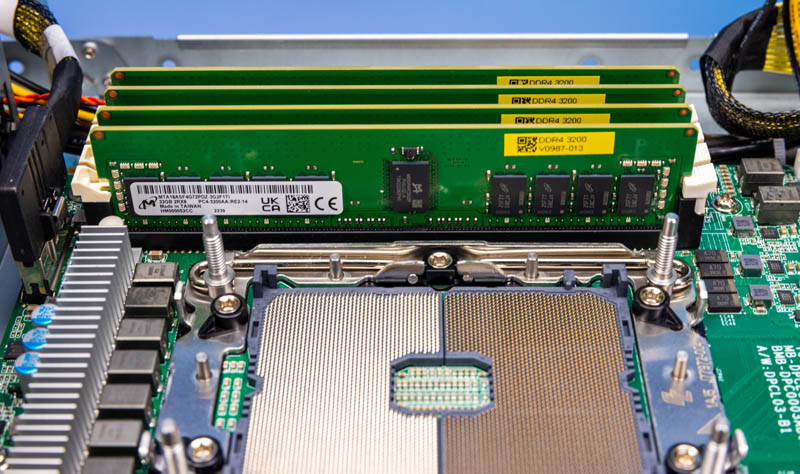

За стеной вентиляторов мы находим процессоры и память. В этой системе мы имеем два сокета под процессоры 3-го поколения Intel Xeon Scalable (Ice Lake), с восемью слотами DIMM DDR4 каждый.

Как вы сами можете видеть, здесь мы используем память Micron. К счастью, у нас есть дополнительные RDIMM-модули Micron DDR4-3200 и процессоры Intel Xeon, чтобы полностью укомплектовать эту двухнодовую конфигурацию, которая рассчитана на четыре процессора и 32 RDIMM-модуля DDR4.

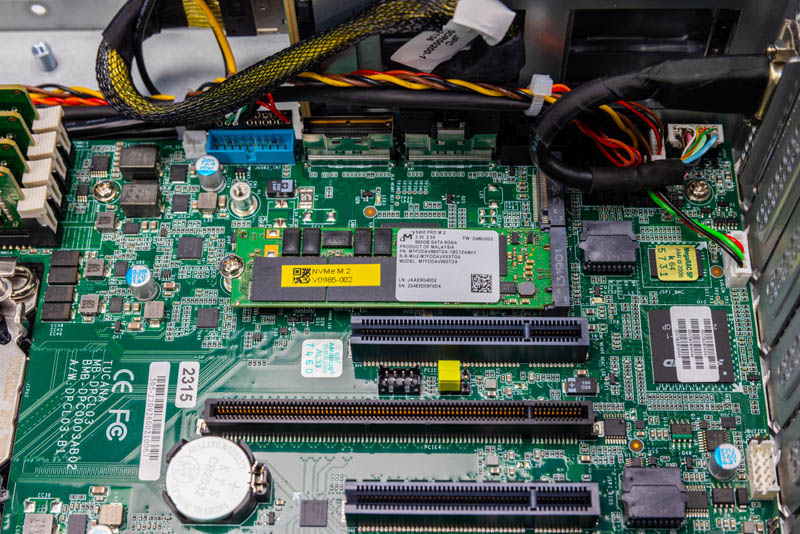

Хотя здесь используются сетевые карты 10Gbase-T и в передней части корпуса размещается инфраструктура SAS3 для накопителей и сетевых подключений, это не единственное, что здесь есть. Внутри корпуса мы также находим пару слотов M.2, которые заняты M.2 SSD, снова от Micron.

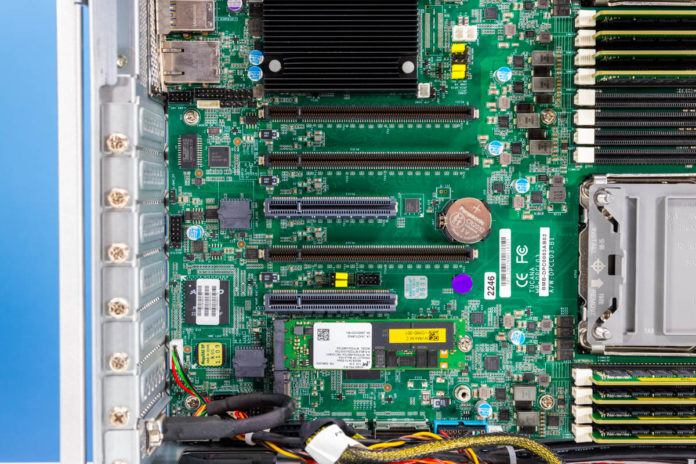

Кроме того, мы видим слоты PCIe: три слота PCIe Gen4 x16 и два слота x8 для сетевых подключений, ИИ-ускорителей (мы пробовали подключать NVIDIA L4, который получал достаточно интенсивный для адекватного охлаждения воздушный поток) и внешних SAS HBA.

Также здесь можно видеть наш контроллер системной платы ASPEED. В качестве управляющего программного обеспечения AIC использует решение American Megatrends MegaRAC, обеспечивающее отраслевой стандарт управления системой через IPMI.

Выше чипсета мы видим еще один слот OCP NIC 3.0 для дополнительных подключений. Вероятнее всего даже, что в таких системах этот слот является основным сетевым слотом.

Преимуществом корпуса платформы с поддержкой SAS3 и двух процессоров является большое количество линий PCIe.

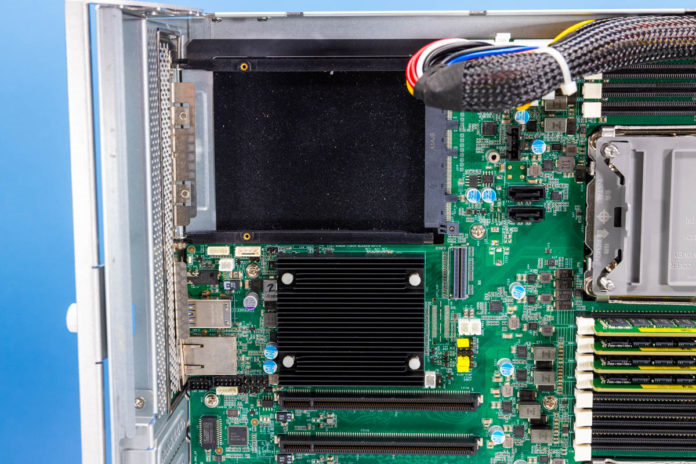

Еще одна отличительная особенность этого сервера – то, что мы имеем дисковые отсеки 2.5″ на задней панели. AIC предлагает опции как для PCIe/ NVMe, так и для SATA дисков. Наша система сконфигурирована под NVMe, что видно по большому кабелю.

Эти задние 2.5-дюймовые отсеки также оснащены удобными салазками, позволяющими устанавливать диски без применения инструментов.

Теперь давайте посмотрим на блок-схему сервера. Здесь очень много функциональных компонентов, поэтому важно представлять себе, как работает вся конфигурация в целом.

СХД AIC HA401-TU: блок-схема

Блок-схема важна для понимания принципа работы сервера и его составных частей. из нее видно, каким образом каждый процессор подключен к остальной системе и какие этажи PCB подключены к передней панели каждой ноды.

Одной из уникальных особенностей сервера является то, что оба процессора подают сигнал на дочернюю плату PCIe, к которой подключены внутренние сетевые карты 10GbE и которая передает сигнал дальше на плату удлинителя.

Блок-схема также показывает количество разных моделей 2.5-дюймовых дисков (NVMe или SATA) для внешних опций подключений на задней панели.

Здесь очень много всего, поэтому, если вас интересует эта серверная система, мы рекомендуем рассмотреть блок-схему более внимательно.

СХД AIC HA401-TU: производительность

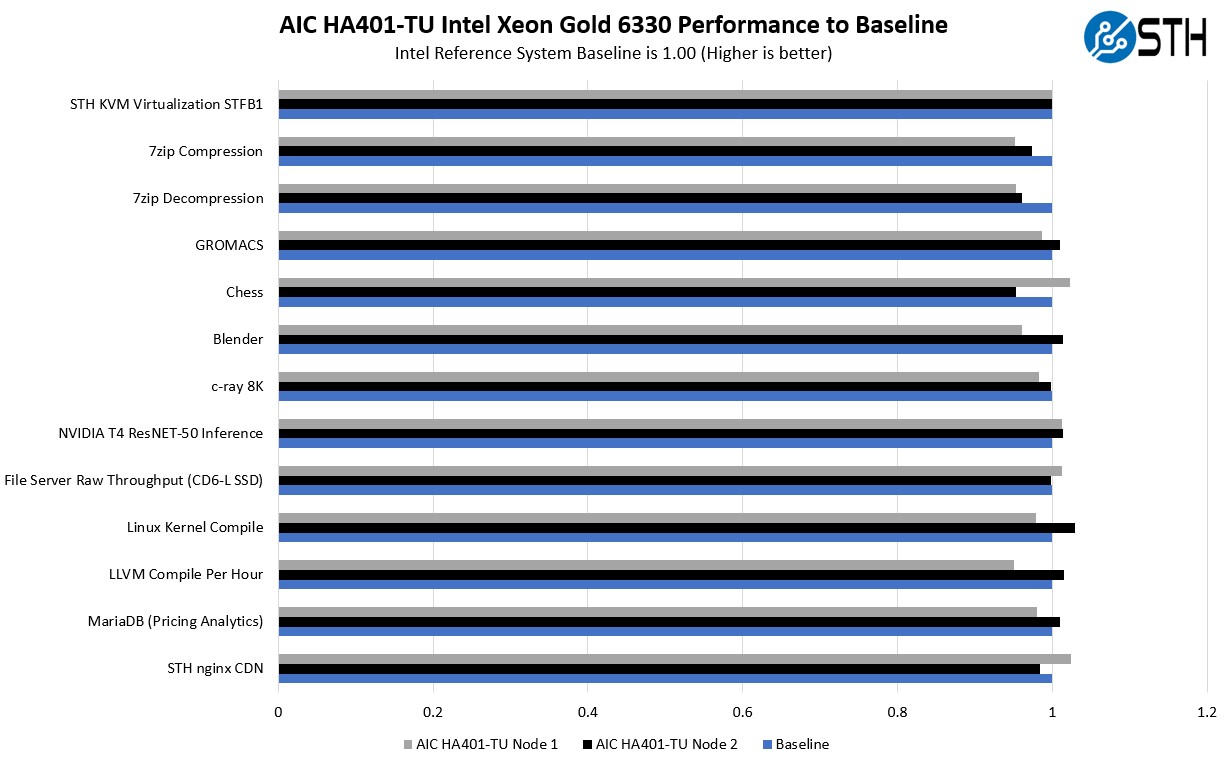

В части производительности мы были немного ограничены выбором CPU. У нас было только несколько процессоров Intel Xeon Platinum 6330. Мы слегка беспокоились по поводу их возможного перегрева в этом сервере, но, судя по результатам, они отработали хорошо.

Вообще это процессоры с довольно высоким TDP (205 Вт), и мы боялись, что получим ужасную производительность, но этого не произошло. Мы получили результаты, близкие к типовым показателям двухъюнитовых серверов, таких, например, как C{L AIC SB201-TU 2U с 24 отсеками NVMe. Вероятно, можно было использовать и 270-ваттные процессоры, но у нас не было подходящего комплекта из четырех штук.

Однако в целом для файловых серверов с быстрым доступом к данным мы обычно рекомендуем процессоры с меньшим TDP, которые лучше приспособлены к этому типу сценариев.

Замечания по части быстрого доступа к данным

В ходе работы над данным обзором мы отметили, что желательно было бы иметь под рукой руководство по быстрому доступу к данным, скажем, для файловой системы ZFS. Хотя есть несколько коммерческих опций ПО, для загрузки системы можно использовать и такие программные компоненты, как Corosync, Pacemaker, Pcsd и Multipathd. Мы по факту использовали дистрибутив RHEL, но, пока мы писали этот обзор, RHEL изменили политику распространения дистрибутивов, поэтому мы в настоящий момент планируем перейти на Debian.

Отметим здесь, что когда мы установили ZFS и запустили систему, то попробовали вытащить ноду из корпуса и в течение нескольких минут вставить ее обратно, чтобы проверить «горячий» функционал быстрого доступа в действии.

Еще одно важное замечание: этот тип оборудования подходит для резервных нод хранения данных значительно лучше, чем, например, NAS QNAP GM-1002 3U Dual ZFS. Хранилище QNAP предлагает две ноды в одном корпусе, причем каждая содержит половину накопителей. А этот сервер предлагает две ноды с возможностью горячей замены, и обе имеют доступ к дискам SAS передней панели, используя при этом стандартные контроллеры Broadcom SAS3 и удлинители и располагая намного большим потенциалом для расширения. То есть мы хотим обратить внимание на то, что многие производители СХД выпускают двухнодовые системы, которые могут выглядеть как системы с быстрым доступом, но до фактически обеспечиваемого быстрого доступа им далеко.

Переходим к энергопотреблению.

Сервер AIC HA401-TU: энергопотребление

В нашем случае система использует два БП класса 80 Plus Platinum мощностью 1.2 кВт. Однако 1.6 кВт – тоже вариант. Мы даже рекомендовали бы более мощную модель, поскольку мы подошли очень близко к номиналу 1.2 кВт, используя процессоры Intel Xeon Gold 6330.

В режиме простоя здесь можно рассчитывать на 250 Вт или на 300 Вт с небольшим. Этот показатель во многом зависит от параметров конкретной конфигурации. В предположении, что сервер будет использоваться по основному назначению – для хранения данных с быстрым доступом, нужно рассчитывать на достаточно высокое энергопотребление инфраструктуры SAS, наряду с активно работающими процессорами, памятью и сетевыми картами.

Следует иметь в виду, что быстрый доступ к данным неизбежно подразумевает большее энергопотребление файлового сервера по сравнению с 24-отсековыми СХД с «обычным» доступом.

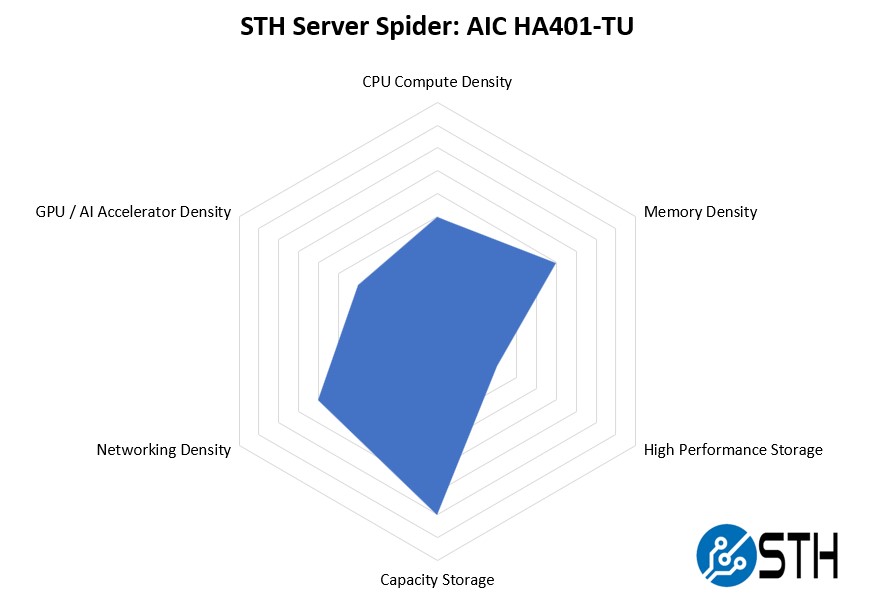

СХД AIC HA401-TU: целевые характеристики

В 2018 году мы представили диаграмму STH Server Spider, которая показывает распределение потенциала серверной системы по различным аспектам. Задача этой диаграммы – дать наглядное представление о том, на какие сценарии в первую очередь рассчитан данный сервер.

Это действительно интересная система. Этот сервер располагает большим вычислительным потенциалом, чем многие четырехъюнитовые СХД, а также большими возможностями для сетевых подключений. В то же время нельзя сказать, что это сервер с самой высокой плотностью, поскольку есть однонодовые четырехъюнитовые файловые серверы с большей плотностью, например, 60-отсековый AIC SB407-TU.

Тем не менее, для четырехъюнитовой модели с быстрым доступом к данным этот сервер предлагает солидную плотность.

Заключение

В целом это интересная и перспективная система. Хотя мы уже видели материнскую плату Toucana, нас весьма впечатлил потрясающий многоуровневый стек платы в этом сервере, как и возможность «горячей замены» нод с непрерывным быстрым доступом к данным.

На наш взгляд, покупать такой сервер стоит главным образом для разработки и/или развертывания оборудования, которому требуется быстрый доступ к данным. Хотя мы посвятили большую часть обзора обсуждению быстрого доступа в контексте самого сервера, многочисленные задние слоты PCIe подразумевают также возможность подключения к серверу внешних дисковых массивов в целях повышения емкости основного массива SAS3, подключенного к двум контроллерам нод. Подключение двух контроллеров к одному набору дисков, размещаемых в нескольких корпусах, – испытанный годами способ надежной организации быстрого доступа к данным в файловых серверах.

В общем, это очень интересный сервер. Когда мы обсуждаем варианты сборки нового продвинутого кластера для хостинга, то часто спорим, что лучше: кластеризованная СХД или система с быстрым доступом. Если ваш приоритет – быстрый доступ, мы рекомендуем присмотреться к этому серверу.

Подождите...

Подождите...