Четверг, 23 ноября 2023 15:56

NVIDIA на SC-23 анонсировала графический ускоритель H200 со 141 ГБ памяти HBM3e

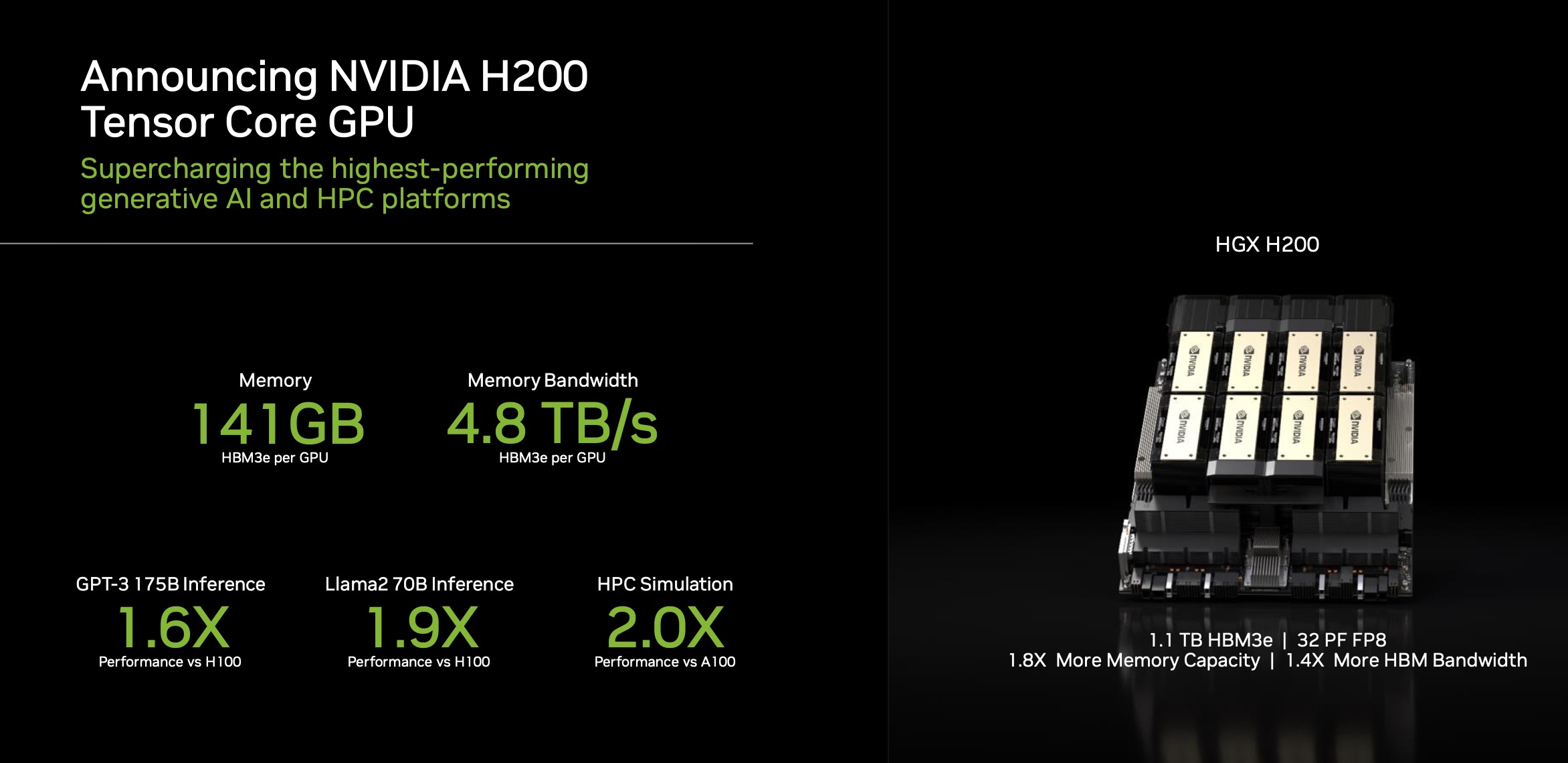

NVIDIA уже выпустила вариант платформы H200 со 141 гигабайтом памяти HBM3e – суперчип Grace Hopper GH200. Теперь мы получили официальный анонс более общей серии 141-гигабайтных ускорителей H200, которые будут доступны в 2024 году.

Новый ускоритель NVIDIA H200 имеет существенное отличие от предшественника, по крайней мере, в одном аспекте. Переход на память HBM3e дает NVIDIA возможность использовать более емкие стеки HBM и в целом получить более высокую производительность. Емкость и пропускная способность памяти обычно являются основными факторами, лимитирующими производительность в сценариях для ИИ и HPC, так что это решение раздвигает рамки в части потенциала памяти.

Посмотрев на модуль H100 SXM5, мы видим шесть стеков HBM, расположенных по периметру графического компонента Hopper. Емкость 141 ГБ не делится ровно на шесть частей, так что можно предположить, что на самом деле там шесть стеков HBM3e емкостью 24 ГБ каждый. Об этом мы писали несколько месяцев назад.

На данный момент известно, что новые модели H200 находятся в процессе производства и поступят к заказчикам в следующем году. Модули SXM5 будут компоноваться в блоки с восемью GPU и поставляться заказчикам, готовым заплатить за такое оборудование.

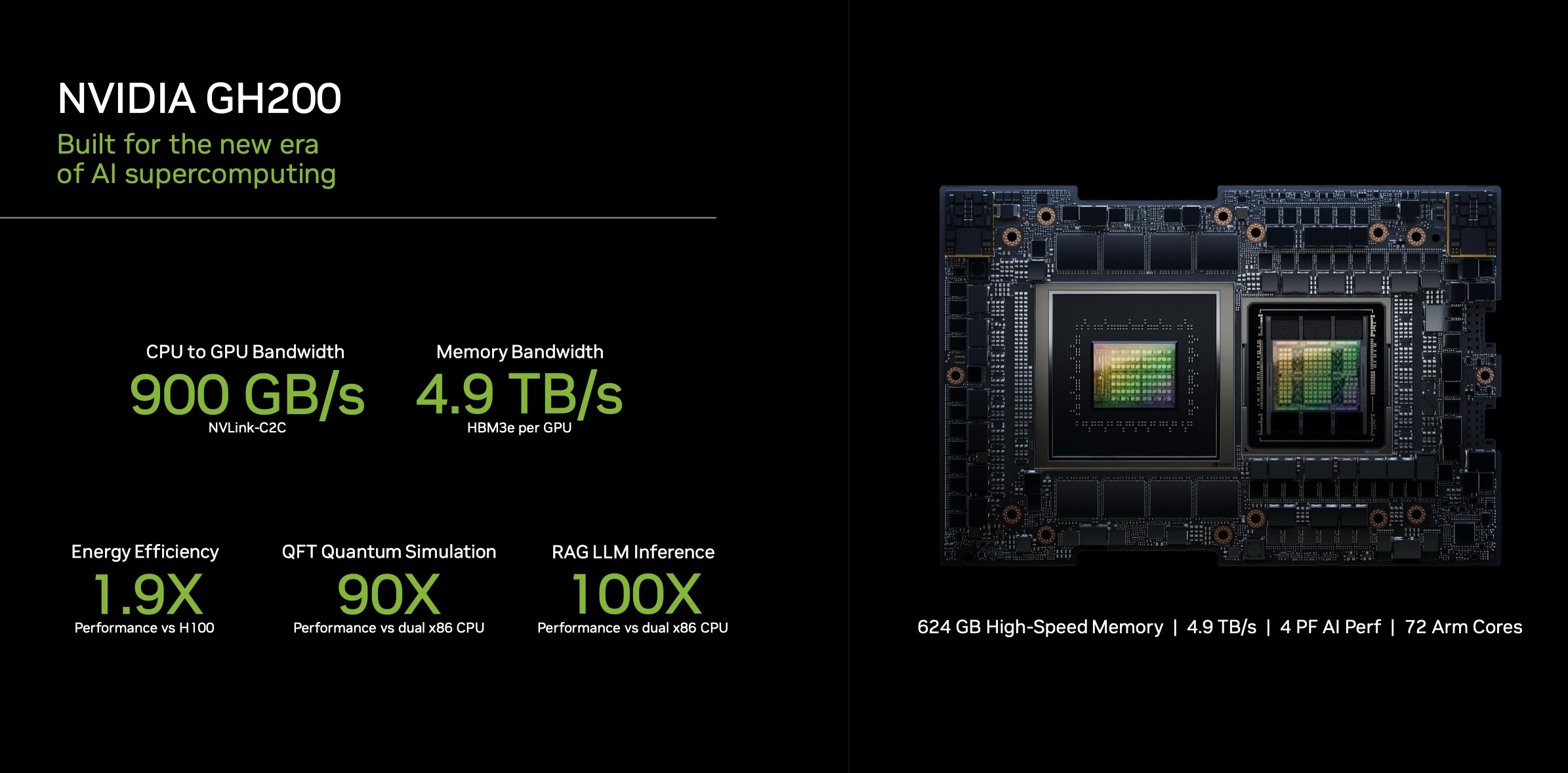

И, конечно, NVIDIA уже выпустила H200 в составе Grace Hopper GH200, в комбинации с 72-ядерным процессором Arm Neoverse V2 в одном модуле (не путать с суперчипом Grace Superchip, который несовместим с H200).

Все это мы увидим уже в следующем году.

Резюме

В целом обновление серии GPU Hopper – значительное событие. Кроме того, если вы еще не знаете, видеокарта A100 сначала вышла в 40-гигабайтной версии, а затем, в ходе модернизации, объем памяти был увеличен до 80 ГБ. Графическая карта для дата-центров V100 была выпущена с объемом памяти 16 ГБ, который, в конце концов, был доведен до 32 ГБ. В случае с Hopper мы имеем дело не с удвоением объема памяти, а с увеличением его на 76% относительно предыдущего поколения. Это может показаться не столь впечатляющим, но если вы купили 8-модульную систему NVIDIA V100 16 ГБ, то каждый новый модуль H200 теперь предлагает больше памяти HBM, что позволяет увеличить объем памяти системы HGX примерно в 8.8 раза.

Если кто-то удивляется, почему мы делаем обзоры платформ HGX с жидкостным охлаждением, таких как сервер для ИИ Supermicro SYS-821GE-TNHR 8x NVIDIA H100, то как раз выход H200 должен стать одним из стимулов для перехода большего числа заказчиков на жидкостное охлаждение. Следующее поколение графических ускорителей NVIDIA сделает использование жидкостного охлаждения более массовым, и мы будем держать вас в курсе последних актуальных новостей.

Источник: www.servethehome.com