Генеральный директор Intel Пэт Гелсингер (Pat Gelsinger) выступил с громким заявлением, сказав, что инференсы являются для отрасли более перспективной технологией, чем вычислительные алгоритмы Nvidia CUDA, поскольку инференсы более эффективно используют ресурсы, адаптируются к изменениям данных без необходимости переучивания модели и потому что подход Nvidia "поверхностный". Но прав ли он? CUDA – текущий отраслевой стандарт, позиции которого выглядят довольно прочными. Однако, стремясь по возможности опередить конкурентов, Intel представляет свое новое портфолио продуктов для ИИ.

На своем мероприятии под названием «ИИ везде» (AI Everywhere), проходившем на прошлой неделе в Нью-Йорк-Сити, компания Intel выставила ряд продуктов для ИИ, предназначенных для дата-центров, облачных и сетевых провайдеров, граничных серверов и пользовательских ПК, включая мобильные. "Задача Intel – обеспечить повсеместное внедрение ИИ посредством применения тщательно продуманных платформ, средств защиты данных и поддержки открытых экосистем," – сказал Гелсингер, представляя новые процессоры Intel Core Ultra для ноутбуков (семейство "Meteor Lake") и процессоры корпоративного класса 5-го поколения Xeon для серверов и дата-центров. Обе линейки чипов предлагают расширенные возможности для использования ИИ наряду со значительными усовершенствованиями в части энергетической эффективности и чистой производительности.

Серия Core Ultra сочетает несколько новых технологий в одной схеме SoC – фактически, Intel сегодня представляет самую большую модернизацию архитектуры своих процессоров за последние 40 лет. И наиболее заметным и значительным нововведением является первый в истории Intel интегрированный нейропроцессор (Neural Processing Unit, NPU), встроенный в схему SoC.

Специализированный блок NPU предназначен для ускорения определенных типов рабочих сценариев для ИИ и, соответственно, высвобождения вычислительных ресурсов CPU и GPU (также встроенных в чип) для выполнения других задач. В перспективе это позволит запускать на ПК новые типы приложений и улучшит показатели времени автономной работы ноутбуков и их общую эффективность.

Это довольно сильная комбинации, которая в парадигме Intel также становится символом начала эры "компьютеров с поддержкой ИИ" (AI PC) – что особенно актуально в свете перемещения фокуса общего внимания на генеративный ИИ, который вышел за пределы сферы интересов узкоспециализированных отраслей и все чаще используется в массовых приложениях.

Главный конкурент Intel – компания AMD – представила свои первые чипы для ПК со встроенным NPU ранее в этом году в серии Ryzen 7040, а совсем недавно была анонсирована обновленная серия Ryzen 8040 с NPU второго поколения.

Однако, с учетом внушительных позиций Intel на компьютерном рынке (а также ограниченной программной поддержки первых NPU от AMD), практически нет сомнений в том, что первые ноутбуки с процессорами Core Ultra – уже доступные на сегодняшний день – для многих станут первым массовым предложением в этом быстро развивающемся сегменте.

С практической точки зрения многие люди оценят более традиционные усовершенствования, включенные в новые чипы Intel, – даже если они не столь будоражат воображение, как NPU. Процессоры Core Ultra предлагают сочетание высокопроизводительных ядер P (до шести в одном чипе) и восьми энергетически эффективных ядер E, а также включают в себя два новых ядра с ультранизким энергопотреблением, образующие так называемый «малопотребляющий остров», который может включаться в режиме низкой нагрузки, обеспечивая более длительное время автономной работы ноутбука.

Новый встроенный графический компонент в Core Ultra базируется на архитектуре Arc и предлагает до восьми графических ядер Xe и впечатляющее – двукратное – увеличение производительности по сравнению с предыдущими встроенными графическими решениями Intel.

Серия Core Ultra представляет интерес и с точки зрения технологий изготовления микросхем. Основной элемент с функцией CPU – это первый чип Intel, изготавливаемый на базе техпроцесса Intel 4 (второй из пяти техпроцессов, которые компания будет использовать в следующие четыре года) и реализующий продвинутую версию технологию объемной компоновки логических микросхем Foveros.

Технология Foveros позволяет Intel включать разные чиплеты, изготавливаемые на основе разных техпроцессов, в одну, более сложную схему SoC.

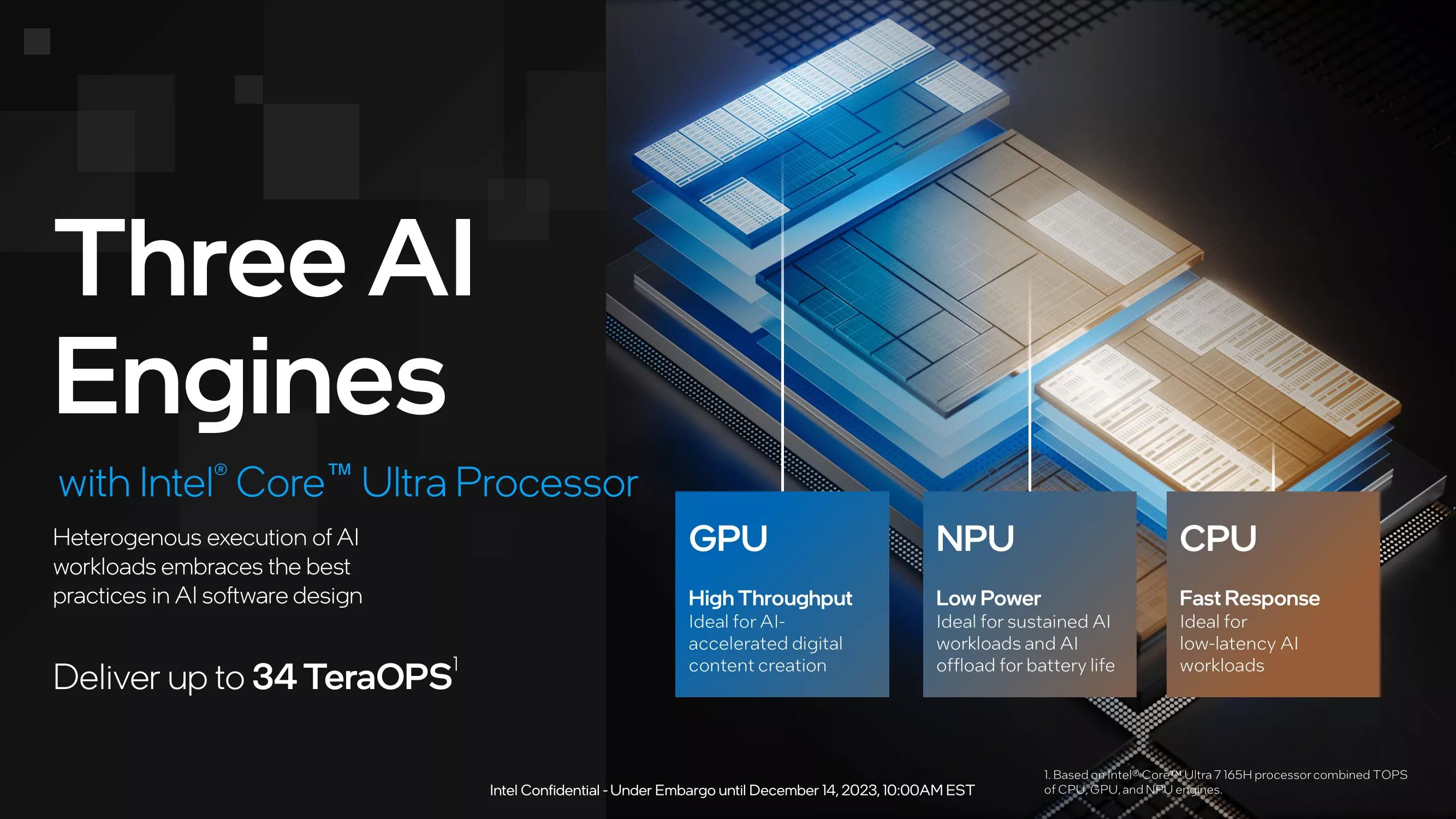

Одна из ключевых стратегий Intel, применяемая в серии Core Ultra как часть более общей концепции AI PC, направлена на максимальную эффективность совместного функционирования NPU, CPU и GPU в рабочих сценариях для ИИ.

В настоящее время в отрасли особое внимание уделяется обеспечению вычислительной мощности NPU порядка десятков TOPS (Tera Operations Per Second, триллионов операций в секунду). Например, грядущие чипы Snapdragon X Elite обещают вычислительную мощность NPU 45 TOPS. Нейропроцессор Intel в чипах Meteor Lake предлагает 10 TOPS, тогда как для недавно обновленного NPU AMD в серии Ryzen 8040 заявлена мощность 16 TOPS.

Стоит отметить, что и Intel, и AMD основное внимание уделяют общей вычислительной мощности процессора в TOPS, признавая, что значительный вклад в этот показатель вносят блоки CPU и GPU. Intel для своих процессоров Core Ultra заявляет общую системную мощность до 34 TOPS, AMD для процессоров Ryzen 8040 – до 39 TOPS.

В настоящее время ведутся многочисленные дискуссии о том, имеют ли показатели TOPS вообще какое-либо практическое значение, и в частности – для NPU. Стараниями Intel и AMD реальные приложения для ИИ уже используют ресурсы CPU и GPU, и через какое-то время в них появится поддержка мощностей NPU. Другими словами, существует не так много приложений, опирающихся исключительно на NPU, поэтому практическая значимость бенчмарков для определения производительности TOPS пока под вопросом.

Вопрос остается спорным еще и потому, что многие сценарии для ИИ, которые потенциально можно реализовать на автономном ПК, на данный момент успешно реализуются через облачные сервисы, без привлечения какого-либо локального процессинга (примеры – ChatGPT, Microsoft 365 и т.д.). Конечно, можно надеяться, что многие из этих задач начнут выполняться локально, но, как обычно бывает, когда дело касается модернизации программных продуктов, это потребует времени.

В то же время уже существует несколько приложений, которые могут начать задействовать аппаратные ресурсы Core Ultra. Наиболее яркий пример – программа SuperPower, которая может записывать все ваши действия на компьютере и потом легко находить нужные, что позволяет вам быстро составлять новый контент (такой как электронные письма и документы) на основе данных, уже имеющихся на вашем ПК.

В настоящее время программа использует версию базисной модели Meta Llama2 с семью миллиардами параметров (7B), но переговоры с разработчиками позволяют сделать вывод, что в будущем могут быть добавлены другие возможности. С практической точки зрения интересно то, что Superpower использует в процессорах Core Ultra как CPU, так и встроенный NPU, представляя собой хороший пример того, в каком направлении могут развиваться реальные приложения для ИИ.

В отличие от версии для Mac, SuperPower на ноутбуках с Core Ultra может работать автономно, используя локальную LLM (языковую модель) и NPU. Машины Mac в настоящее время не содержат встроенных NPU, поэтому им для работы с этой программой требуется подключение к интернету. Еще один демонстрационный пример, созданный Intel совместно с HP, представляет собой игровой приложение, которое осуществляет стриминг силами NPU, полностью высвобождая ресурс GPU собственно для игры.

Все это интересно, но у многих людей может возникнуть вполне закономерный вопрос: что означает приход AI PC для среднего пользователя ПК, как в бизнесе, так и в повседневной жизни?

Присутствовавшая на упомянутом выше мероприятии Мишель Джонстон Холтхаус (Michelle Johnston Holthaus), исполнительный вице-президент и генеральный менеджер группы клиентского компьютинга Intel, дала на этот вопрос честный ответ: это только начало, и с точностью они ничего сказать не могут. Понятно, что массовые ПК с поддержкой ИИ – это заявка на концептуально новую практику использования этих устройств в будущем. Однако очевидно, что люди все-таки задумываются – а что конкретно из этого выйдет, и Intel, по крайней мере, отдает себе в этом отчет.

Усилия Intel, как многолетнего лидера в области процессоростроения, по продвижению идеи массовых персональных компьютеров с поддержкой искусственного интеллекта, без сомнения, важны и заслуживают внимания. Помимо масштабной PR-кампании, Intel также работает более чем со 100 разработчиками программного обеспечения над увеличением количества ИИ-приложений на рынке. Располагая огромной инфраструктурой и развитой экосистемой, которую они создали за последние десятилетия, Intel может оказать значительное влияние на ход реализации идеи массового внедрения ПК с поддержкой ИИ на рынок. И, учитывая, что в целом идея перехода на ПК с возможностью локального запуска ИИ-приложений, вероятнее всего, будет одобрена, очень важно посмотреть на первые шаги компании в этом направлении.

Новые продукты Intel получили должное внимание со стороны прессы, инвесторов и заказчиков, но едва ли не больший интерес представляют высказывания Гелсингера о технологии Nvidia CUDA: как она, по его мнению, в обозримом будущем может кануть в небытие.

"Вы знаете, что вся отрасль заинтересована в сворачивании рынка CUDA," – сказал Гелсингер, ссылаясь на MLIR, Google и OpenAI как на авангард перехода на "программный фундамент языка Python" в целях повышения открытости обучения ИИ.

В конечном счете, заявил Гелсингер, технологии инференсов в перспективе имеют большее значение для развития сферы ИИ, чем ускоренное обучения моделей, так как CUDA-подход является "поверхностным и ограниченным". Отрасль нуждается в более широком наборе технологий для машинного обучения, инноваций и развития науки о данных (data science), добавил он. В числе преимуществ инференсов – независимость обученной модели от CUDA: компания-заказчик может запускать инференс на любой платформе.

Злые языки могут заметить, что пренебрежительное отношение Гелсингера к технологиям ускорения обучения ИИ обусловлено отсутствием у Intel значительных подвижек в этой области. Инференс, по сравнению с обучением модели, требует меньше вычислительных мощностей и может адаптироваться к быстро меняющимся данным без необходимости переучивания модели – такова основная идея Гелсингера.

Однако из его высказываний также следует, что Nvidia, которая продвигается на рынке ИИ семимильными шагами, становится главным противником. Согласно опубликованному в прошлом месяце финансовому отчету, выручка компании за третий квартал составила 18.12 млрд долларов, что на 206% больше, чем год назад, и на 34% больше, чем в предыдущем квартале этого года, и, по словам генерального директора Nvidia Дженсена Хуанга (Jensen Huang), этот рост обусловлен переходом отрасли от универсальных вычислительных платформ к компьютингу на базе аппаратных ускорителей и генеративным моделям ИИ. Графические и центральные процессоры Nvidia, сетевые решения, программное обеспечение ИИ и онлайн-сервисы – всё "на полном ходу", заявил Хуанг.

Сбудутся или нет прогнозы Гелсингера относительно CUDA, покажет время, но на данный момент эта технология для отрасли практически является повсеместно используемым стандартом.

В то же время, Intel тоже может похвастаться примерами из своей базы заказчиков, которые используют инференсы для решения своих задач. Один из них, Мор Миллер (Mor Miller), вице-президент департамента развития бизнеса Bufferzone, недавно объяснил, что скрытость, приватность и стоимость использования ресурса могут стать проблемой для клиентов облачных ИИ-сервисов. И их компания совместно с Intel разрабатывает новый ИИ-инференс, который поможет решить эти проблемы.

Подождите...

Подождите...