После нескольких лет, проведенных в виртуальном формате, конференция NVIDIA GPU Technology Conference (GTC) возвращается в формат очных встреч. Это фантастическое мероприятие дает возможность изобретателям, ученым, исследователям и энтузиастам компьютерных технологий познакомиться с новейшими достижениями гиганта этой отрасли. В этом году, на GTC-2024, NVIDIA представила техническому сообществу свои последние инновации в области ИИ, глубокого обучения, беспилотного транспорта, а также новую графическую архитектуру Blackwell.

В этой статье мы осветим основные пункты доклада генерального директора NVIDIA, Дженсена Хуанга (Jensen Huang), которые охватывают архитектуру Blackwell, сетевые решения, успехи квантового компьютинга и модернизацию программного обеспечения.

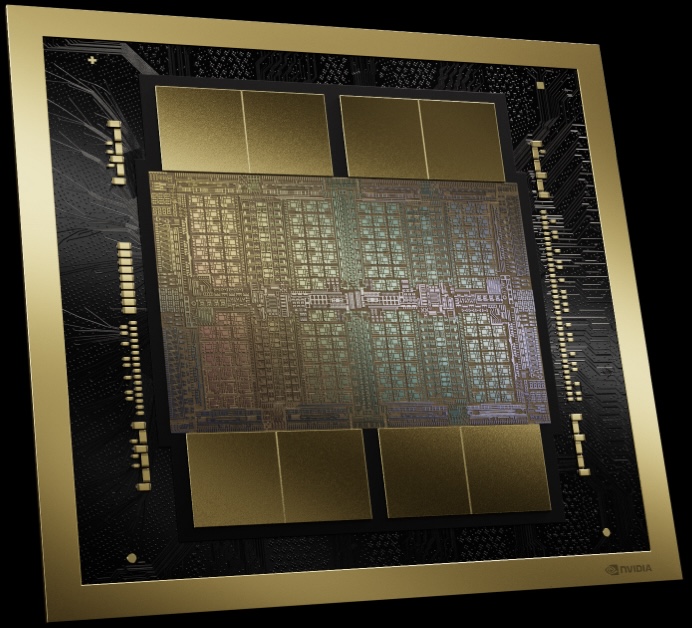

Графическая архитектура NVIDIA Blackwell

В основе инновации Blackwell лежит сбалансированное сочетание шести революционных технологий, позволившее усовершенствовать механизм аппаратного ускорения вычислений. Это новый стандарт эффективности от NVIDIA для самых разных приложений – от дата-процессинга до поиска новых лекарственных формул. Авторитетные заказчики, такие как Amazon и Microsoft, уже выразили заинтересованность в новых возможностях Blackwell.

Давайте посмотрим, из чего складывается столь мощное инженерное решение NVIDIA. Графические процессоры Blackwell включают в себя потрясающие 208 млрд транзисторов, занимающих два чиплета, которые производятся на пределе сетки (reticle limit) техпроцесса TSMC 4NP. Этот подход расширяет границы полупроводниковых технологий и предлагает новый путь – соединение чиплетов интерфейсом со сверхвысокой пропускной способностью: 10 ТБ/с. Переход на чиплетные технологии показывает, что NVIDIA собирается преодолеть традиционные ограничения на число транзисторов в микросхеме.

Сравнение спецификаций Hopper и Blackwell

| Спецификация |

H100 |

B100 |

B200 |

| Максимальный объем и тип памяти |

80 ГБ HBM3 |

192 ГБ HBM3e |

192 ГБ HBM3e |

| Пропускная способность памяти |

3.35 ТБ/с |

8 ТБ/с |

8 ТБ/с |

| FP4 |

-- |

14 PFLOPS |

18 PFLOPS |

| FP6 |

-- |

7 PFLOPS |

9 PFLOPS |

| FP8/INT8 |

3.958 PFLOPS/POPS |

7 PFLOPS/POPS |

9 PFLOPS/POPS |

| FP16/BF16 |

1979 TFLOPS |

3.5 PFLOPS |

4.5 PFLOPS |

| TF32 |

989 TFLOPS |

1.8 PFLOPS |

2.2 PFLOPS |

| FP64 |

67 TFLOPS |

30 TFLOPS |

40 TFLOPS |

| Максимальное энергопотребление |

700 Вт |

700 Вт |

1000 Вт |

Примечание: здесь и далее все числовые характеристики вычислительной мощности относятся к операциям с разреженными матрицами.

Увеличение количества транзисторов – это еще не всё. Введение опций точности вычислений FP4 и FP6 открывает новый уровень эффективности ускоренного обучения моделей ИИ, хотя и ценой небольшого компромисса в части производительности модели. Этот компромисс, отражающий сложность нахождения оптимального баланса между точностью и эффективностью, будет зависеть от настроек платформы.

Движок-трансформер 2-го поколения в чипах Blackwell при использовании FP4 обеспечивает значительный прогресс в части скорости и объема вычислений, а также размера «обслуживаемой» модели ИИ, что является важнейшими усовершенствованиями в плане будущего развития ИИ-технологий. Более того, интеграция интерфейса PCIe Gen6 и новой технологии памяти HBM3e обусловила значительное повышение пропускной способности чипа, которое, при одновременном использовании 5-го поколения NVLink, дает двукратное превосходство над архитектурой предыдущего поколения: в результате мы получаем фантастические 1.8 ТБ/с.

Одно из наиболее интригующих нововведений – движок RAS Engine, повышающий надежность, доступность и простоту обслуживания серверных конфигураций для ИИ. Эта инновация потенциально может значительно улучшить показатели использования вычислительной мощности моделей ИИ и, таким образом, решить одну из важнейших проблем масштабирования приложений ИИ.

Архитектура NVIDIA Blackwell несет с собой новые возможности конфиденциального компьютинга, предлагая в том числе – впервые в сегменте графических процессоров –технологию доверительных сред исполнения (Trusted Execution Environment, TEE), которая теперь поддерживается не только CPU, но и GPU. Это гарантирует безопасную и быструю обработку конфиденциальных данных, что крайне важно в аспекте обучения генеративного ИИ. Данная инновация имеет наибольшее значение для отраслей, имеющих дело с проприетарной информацией или повышенными требованиями в части конфиденциальности. Концепция конфиденциального компьютинга NVIDIA Blackwell предлагает беспрецедентный уровень информационной безопасности практически без ущерба для производительности, обеспечивая почти одинаковую пропускную способность в режимах с шифрованием данных и без него. Это не только защищает большие модели ИИ, но также позволяет осуществлять конфиденциальные тренинги ИИ и федеративное машинное обучение, гарантируя защиту интеллектуальной собственности в сфере ИИ.

Распаковочный движок Decompression Engine в NVIDIA Blackwell демонстрирует значительный прогресс в дата-аналитике и управлении рабочими потоками баз данных. Этот движок может распаковывать данные с потрясающей скоростью – до 800 ГБ/с, что значительно ускоряет аналитику и сокращает время, требуемое для инсайтов. В комбинации с подсистемой памяти HBM3e с пропускной способностью 8 ТБ/с и высокоскоростным интерфейсом NVLink-C2C он ускоряет обработку запросов в БД на Blackwell в 18 раз по сравнению с CPU и в 6 раз по сравнению с предыдущими GPU NVIDIA, согласно результатам бенчмарков. Эта технология поддерживает новейшие форматы сжатия данных и делает графические процессоры NVIDIA Blackwell мощным инструментом для дата-аналитики, который позволяет значительно ускорить весь аналитический пайплайн.

И, несмотря на все эти чудеса техники, NVIDIA заявляет о снижении операционных расходов на эксплуатацию и энергообеспечение инференсов LLM аж в 25 раз, что звучит особенно удивительно при отсутствии детальной информации по энергопотреблению. Тем не менее, это заявление стоит отметить, поскольку выгода может следовать из всесторонней оценки перехода на новые чипы.

В общем, платформа NVIDIA Blackwell – это концептуальная разработка, которая может служить символом неуклонного стремления компании к расширению возможностей ИИ и высокопроизводительных вычислительных систем. Амбициозные цели и революционные технологии, заложенные в Blackwell, – это не шаг, а гигантский скачок вперед, который обещает стать технологической базой для различных преобразований в различных отраслях. По мере того, как мы углубляемся в эру ускоренных вычислений и генеративного ИИ, инновации NVIDIA могут стать катализаторами следующей промышленной революции.

Серверная платформа NVIDIA Blackwell HGX

Опираясь на архитектуру Blackwell, NVIDIA также обновила серверную платформу HGX и серию системных плат. Это весьма убедительная модернизация относительно предыдущего поколения, которая приводит к заметному снижению совокупной стоимости системы на фоне впечатляющего прироста производительности. Сравнение с предыдущим поколением достаточно контрастно – когда мы сравниваем показатели FP8 и FP4, обращает на себя внимание 4.5-кратное увеличение производительности. И даже сравнивая «одноименные» показатели FP8, мы видим, что здесь производительность относительно предшествующего аналога выросла почти вдвое. Этот прогресс касается не только чистой скорости; также значительно выросла эффективность памяти, в частности, агрегированная пропускная способность – в 8 раз, до 64 ТБ/с.

| Спецификация |

HGX H100 |

HGX H200 |

HGX B100 |

HGX B200 |

| Максимальный объем и тип памяти |

640 ГБ HBM3 |

1.1 ТБ HBM3e |

1.5 ТБ HBM3e |

1.5 ТБ HBM3e |

| Пропускная способность памяти |

7.2 ТБ/с |

7.2 ТБ/с |

8 ТБ/с |

8 ТБ/с |

| FP4 |

-- |

-- |

112 PFLOPS |

144 PFLOPS |

| FP6 |

-- |

-- |

56 PFLOPS |

72 PFLOPS |

| FP8/INT8 |

32 PFLOPS/POPS |

32 PFLOPS/POPS |

56 PFLOPS/POPS |

72 PFLOPS/POPS |

| FP16/BF16 |

16 PFLOPS |

16 PFLOPS |

28 PFLOPS |

36 PFLOPS |

Суперчип NVIDIA Grace-Blackwell

Продвигаясь дальше в мир инноваций NVIDIA, обращаем внимание на суперчип GB200 – один из краеугольных камней платформы. В рамках концепции непрерывного развития высокопроизводительных вычислительных систем NVIDIA процессор GB200 представляет значительное расширение модели GPU, сочетая в себе передовые технологии и стратегические усовершенствования в части интерфейсов и масштабируемости. Суперчип GB200 содержит два графических компонента B200; в отличие от конфигурации предыдущего поколения GH200, в которой использовалось соединение одного чипа GPU с одним чипом CPU Grace, в этот раз оба GPU B200 подключены к одному и тому же CPU Grace через интерфейс C2C (chip-to-chip) 900 ГБ/с.

| Спецификация |

GH200 |

GB200 |

| Максимальный объем и тип памяти |

144 ГБ HBM3e |

384 ГБ HBM3e |

| Пропускная способность памяти |

8 ТБ/с |

16 ТБ/с (агрегированная) |

| FP4 |

-- |

40 PFLOPS |

| FP6 |

-- |

20 PFLOPS |

| FP8/INT8 |

3.958 PFLOPS/POPS |

20 PFLOPS |

| FP16/BF16 |

1979 TFLOPS |

10 PFLOPS |

| TF32 |

989 TFLOPS |

5 PFLOPS |

| FP64 |

67 TFLOPS |

90 TFLOPS |

| Конфигурация PCIe |

4x PCIe Gen 5 x16 |

2x PCIe Gen 6 x16 |

| Максимальное энергопотребление |

1000 Вт |

2700 Вт |

На первый взгляд может показаться, что решение использовать интерфейс предыдущего поколения C2C 900 ГБ/с потенциально ограничивает пропускную способность и производительность нового суперчипа. Однако за этим стоит продуманная стратегия опоры на существующие технологии на время подготовительного периода, пока будет разрабатываться база для нового уровня масштабируемости. Архитектура GB200 позволяет соединить до 576 графических чипов с пропускной способностью соединения 1.8 ТБ/с, обеспечиваемой 5-м поколением NVLink. Данный уровень интерконнекта имеет важнейшее значение для построения мощных параллельных вычислительных сред, необходимых для обучения и развертывания самых больших и сложных моделей ИИ.

Модернизация сетевых платформ NVIDIA

Благодаря интеграции GB200 с новейшими сетевыми технологиями NVIDIA платформы Quantum-X800 InfiniBand и Spectrum-X800 Ethernet позволяют по-новому взглянуть на вопросы подключений и пропускной способности. Упоминание в докладе скоростного потенциала 800 Гбит/с указывает на то, что NVIDIA исследует тему преимуществ, которые может принести интерфейс PCIe Gen6.

Конфигурация GB200 с двумя графическими компонентами и продвинутыми опциями подключений представляет точку зрения NVIDIA на будущее высокопроизводительных вычислительных систем (HPC). И эта точка зрения ориентирована не только на «сырую» производительность отдельных компонентов, но даже в большей степени на то, как эти компоненты могут быть организованы в когерентной масштабируемой системе. Увеличивая значимость интерконнекта и баланса между вычислительной мощностью и скоростью передачи данных, NVIDIA решает некоторые из наиболее актуальных проблем, стоящих перед отраслью исследований и разработок в области ИИ, особенно с учетом экспоненциального роста размеров моделей и соответствующих требований к вычислительным системам.

Пятое поколение NVLink и коммутаторы NVLink

Выход 5-го поколения интерконнекта NVLink стал значительной вехой в истории развития сегментов HPC и ИИ. Эта технология повышает емкость, пропускную способность и быстродействие подключений и коммуникаций между GPU, что является крайне важным аспектом в условиях роста требований со стороны быстро развивающихся фундаментальных моделей ИИ.

В 5-м поколении NVLink емкость интерфейса увеличилась до 576 GPU, что существенно больше по сравнению с лимитом предыдущего поколения – 256 GPU. Этот рост сопряжен также с удвоением пропускной способности – исключительно важный показатель для обеспечения производительности фундаментальных моделей ИИ, становящихся все более сложными.

Каждый коммуникационный канал GPU Blackwell предлагает двойное двунаправленное высокоскоростное соединение, как и в GPU Hopper, но теперь эффективная пропускная способность канала составляет 50 ГБ/с в каждом направлении. Новые GPU оснащаются 18 каналами 5-го поколения NVLink, что в совокупности дает потрясающую пропускную способность – 1.8 ТБ/с. Это более чем в 14 раз превосходит пропускную способность текущего поколения PCIe Gen5.

Еще одно замечательное решение – коммутатор NVIDIA NVLink Switch, который поддерживает пропускную способность GPU 130 ТБ/с в одном домене NVLink из 72 GPU (NVL72), что крайне актуально для распараллеливания моделей. Этот коммутатор также предлагает 4-кратное увеличение эффективной пропускной способности благодаря поддержке нового масштабируемого иерархического агрегационно-редукционного протокола NVIDIA SHARP (Scalable Hierarchical Aggregation and Reduction Protocol) для FP8.

Кроме того, коммутатор NVLink теперь дополнен технологией NVIDIA Unified Fabric Manager (UFM), которая обеспечивает надежное управление конфигурацией подключений NVLink.

Стоечное решение для экзавычислений

Построенная на внушительном фундаменте, заложенном предыдущей платформой GraceHopper GH200 NVL32, новая серверная платформа DGX GB200 NVL72 – это не просто апгрейд; это кардинальное усовершенствование, открывающее новые горизонты вычислительной мощности и эффективности. Платформа DGX GB200 NVL72 представляет грандиозные инновации во всех аспектах. Каждый сервер DGX GB200 NVL72 включает в себя 18 нод GB200 SuperChip, каждая их которых содержит два графических процессора GB200.

Эта платформа предлагает более чем двукратное увеличение количества GPU-компонентов – 72 вместо 32 – и умеренное увеличение количества CPU – 36 вместо 32. В то же время апгрейд памяти весьма значителен – с 19.5 ТБ до впечатляющих 30 ТБ. И это не просто внушительные цифры; это новый уровень вычислительных возможностей, рассчитанный на наиболее сложные модели ИИ и приложения для моделирования различных объектов, процессов и систем.

Один из наиболее впечатляющих показателей – вычислительная мощность: платформа скакнула со 127 петафлопс на 1.4 экзафлопс, если сравнивать производительность FP4, которая выросла примерно в 11 раз. Это снова наглядно показывает основной приоритет NVIDIA: расширение границ точности и скорости вычислений, особенно в области машинного обучения и приложений для ИИ. Однако, даже если сравнивать одноименные показатели FP8, платформа демонстрирует увеличение производительности со 127 до 720 петафлопс, подчеркивая прогресс в части вычислительной мощности и эффективности.

Ставка на полностью водяное охлаждение отражает внимание NVIDIA к вопросам стабильности работы и оптимизации производительности северных систем. Этот подход не только позволяет снизить операционные расходы, но и отвечает общей тенденции к повышению экологичности дата-центров.

Суперкомпьютер NVIDIA DGX SuperPOD на базе суперчипов NVIDIA GB200 Grace Blackwell

NVIDIA также анонсировала суперкомпьютер следующего поколения для ИИ – DGX SuperPOD, включающий в себя восемь систем NVIDIA GB200 NVL72 Grace Blackwell. Эта солидная суперконфигурация разработана в расчете на модели ИИ с триллионами параметров и предлагает 11.5 экзафлопс вычислительной мощности в ИИ-приложениях с точностью FP4 в масштабируемой стоечной архитектуре с жидкостным охлаждением. Каждая система GB200 NVL72 включает в себя 36 суперчипов NVIDIA GB200, что подразумевает 30-кратное увеличение производительности инференсов больших языковых моделей (LLM) по сравнению с предыдущей платформой H100.

По словам Дженсена Хуанга, суперкомпьютер DGX SuperPOD проектировался как “фабрика для промышленной революции эпохи ИИ”.

Облачный квантовый симулятор Quantum Simulation Cloud

NVIDIA также представила новый облачный сервис Quantum Simulation Cloud, предназначенный для исследования квантовых вычислений в различных научных областях. Это сервис базируется на открытой платформе CUDA-Q и предлагает мощные инструменты и среды интеграции для построения и тестирования квантовых вычислительных алгоритмов и приложений. Сотрудничество с Университетом Торонто и такими компаниями, как Classiq и QC Ware, показывает заинтересованность NVIDIA в скорейшем внедрении инноваций в области квантовых вычислений.

Программный пакет NVIDIA NIM

Еще одна важная новость – анонс выпуска программного пакета NVIDIA NIM, которые предлагает десятки микросервисов с генеративным ИИ для предприятий. Эти сервисы позволят предприятиям создавать и развертывать кастомные приложения на своих платформах, оптимизировать инференсы на популярных моделях ИИ и совершенствовать свои разработки, используя микросервисы NVIDIA CUDA-X для широкого диапазона приложений. Дженсен Хуанг подчеркнул, что эти микросервисы потенциально способны преобразовать предприятия ряда отраслей в организации с реально работающей инфраструктурой ИИ.

Вычислительные системы OVX

Отвечая быстрым темпам развития генеративного ИИ в различных отраслях, NVIDIA представила вычислительные системы OVX – решение, разработанное с целью оптимизации сложных графических и ИИ-нагрузок. Осознавая крайнюю значимость высокопроизводительных накопителей и подсистем хранения данных для развертывания ИИ, NVIDIA инициировала партнерскую программу валидации систем и устройств хранения данных, в которой приняли участие такие ведущие компании, как DDN, Dell PowerScale, NetApp, Pure Storage и WEKA.

Новая программа устанавливает для компаний-партнеров стандарт валидации систем и устройств хранения данных, гарантирующий оптимальную производительность и возможности масштабирования для корпоративных ИИ-приложений. Эти системы и устройства будут проходить разработанную в NVIDIA строго определенную процедуру тестирования, подтверждающую их соответствие по ряду параметров требованиям современных приложений для ИИ.

Кроме того, сертифицированные NVIDIA серверы OVX на базе графических процессоров NVIDIA L40S, интегрированные с разносторонними программными и сетевыми решениями, предлагают гибкую архитектуру, адаптируемую под различные среды дата-центров. Этот подход позволяет не только ускорять вычисления с резидентными данными, но также отвечает уникальным требованиям генеративных ИИ-приложений, гарантируя их целевую эффективность и рентабельность. Серверы NVIDIA OVX оснащаются мощными GPU и предлагают улучшенную производительность вычислений, быстрый доступ к данным и низкую сетевую задержку. Это особенно актуально для требовательных приложений, таких как чат-боты и поисковые инструменты, которые задействуют расширенную обработку данных.

Сертифицированные NVIDIA серверы OVX уже доступны и выпускаются такими ведущими производителями готовых систем, как GIGABYTE, Hewlett Packard Enterprise, Lenovo и Supermicro; они представляют значительный прогресс в сфере аппаратного обеспечения сложных сценариев для ИИ, гарантируя производительность индустриального класса, масштабируемость и защиту данных.

Заключение

Кроме того, на конференции были представлены разработки в сфере беспилотного транспорта, робототехники, медицины и генеративных приложений ИИ. Все это показывает приверженность NVIDIA инновациям, результатом которых становится практическое применение продвинутых инструментов и платформ ИИ в самых различных областях. Эти высокие технологии включают в себя массу сложностей; особенно это касается квантовых вычислений и программных продуктов. Оставайтесь с нами и будьте в курсе всех последних событий, происходящих в стремительно развивающейся отрасли искусственного интеллекта.

Подождите...

Подождите...