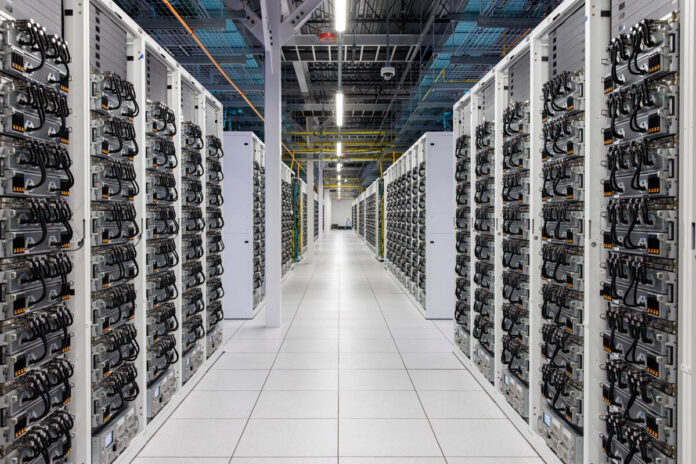

Сегодня мы совершим экскурсию на суперкомпьютер xAI Colossus. Вероятно, вы уже слышали о строительстве силами xAI – стартапа Илона Маска (Elon Musk) – гигантского суперкомпьютера для ИИ в Мемфисе, так вот это тот самый кластер. Этот ИИ-кластер стоимостью в несколько миллиардов долларов, оснащенный 100 тысячами графических ускорителей NVIDIA H100, впечатляет не только своими размерами, но и рекордно короткими сроками, за которые он был построен. Команде стартапа удалось построить этот колоссальный кластер всего за 122 дня. И сегодня мы покажем вам внутренние помещения этого комплекса зданий и сооружений.

Обычно мы пишем полностью независимые статьи, но здесь особый случай, ведь с ЦОД используются серверы Supermicro. Некоторые вещи преднамеренно затушеваны из соображений конфиденциальности, что было условием нашего посещения самого большого в мире вычислительного кластера для ИИ. Мы публикуем эту статью только после того, как ее содержание было одобрено Илоном Маском и его командой.

Стойки Supermicro с жидкостным охлаждением в xAI

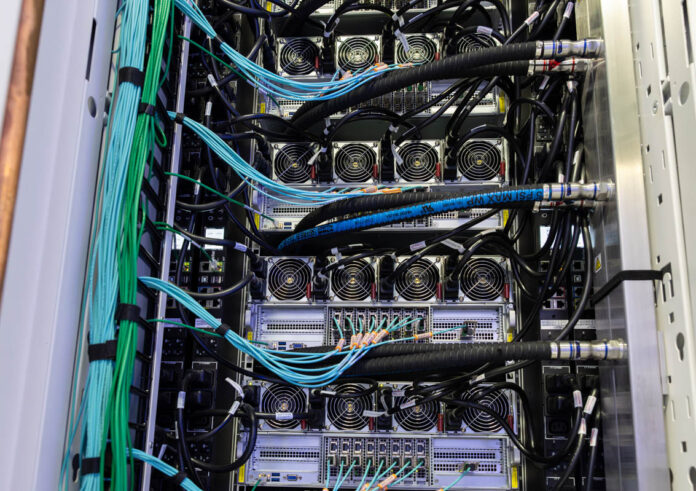

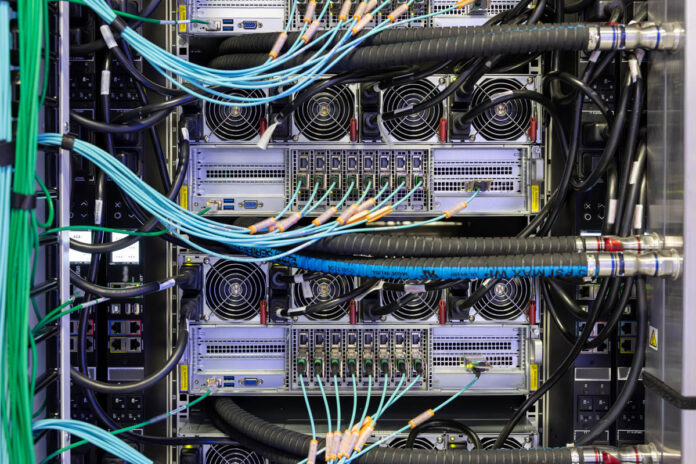

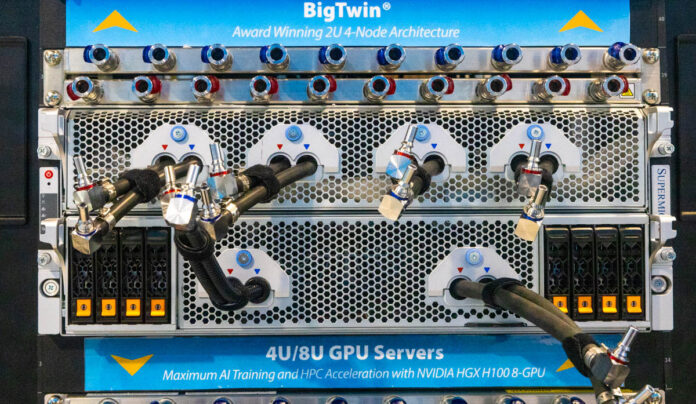

Основными «кирпичиками» Colossus являются стойки Supermicro с жидкостным охлаждением. Одна такая стойка вмещает восемь серверов 4U с восемью ускорителями NVIDIA H100 каждый, то есть в общей сложности получается 64 графических ускорителя на стойку. Восемь графических серверов вместе с блоком распределения хладагента (CDU) Supermicro и связанным оборудованием образуют графическую стоечную вычислительную единицу кластера.

Стойки объединены в группы по восемь единиц (512 GPU); вместе с сетевым оборудованием такая группа образует мини-кластер в составе гораздо большей вычислительной системы.

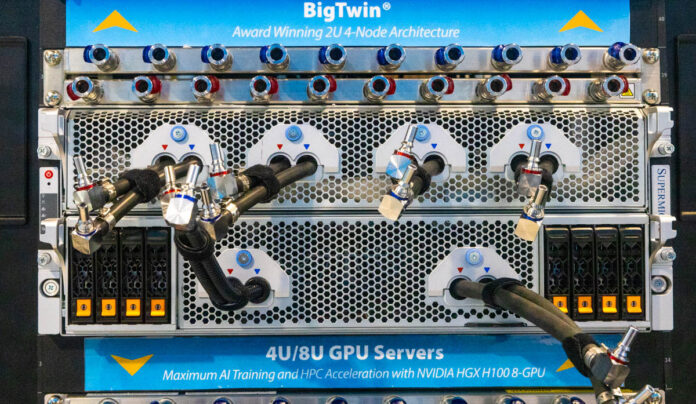

Здесь xAI использует четырехъюнитовые графические серверы Supermicro 4U Universal. Это самые продвинутые серверы для ИИ из представленных на рынке сегодня, и вот почему. Во-первых, их отличает уровень жидкостного охлаждения, во-вторых – удобство обслуживания.

Впервые мы увидели прототип этих систем на выставке Supercomputing-2023 (SC-23) в Денвере примерно год назад. Здесь, в Мемфисе, мы не могли просто взять и открыть какой-нибудь сервер, потому что они были заняты тренингом нейросетей. Но обратите внимание, что выдвижные серверные полки допускают техническое обслуживание оборудования без демонтажа корпусов из стоек. Стоечный трубопровод 1U участвует в подаче хладагента в каждый сервер и отводе нагретой жидкости. Система быстрого отключения позволяет оперативно отключить контур охлаждения, и, как мы сами видели в прошлом году, отключение и подключение СЖО можно производить одной рукой. После отключения контура охлаждения можно выдвигать полки для выполнения работ по обслуживанию оборудования.

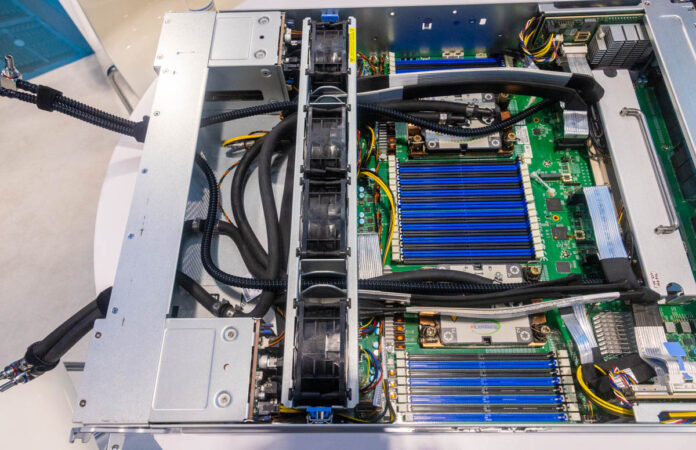

К счастью, у нас есть фото прототипа этого сервера в открытом виде, так что вы можете посмотреть, что внутри. Помимо платы NVIDIA HGX на восемь GPU, которая использует кастомные водоблоки Supermicro, плата CPU также показывает, почему эти серверы представляют принципиально новый для отрасли дизайн.

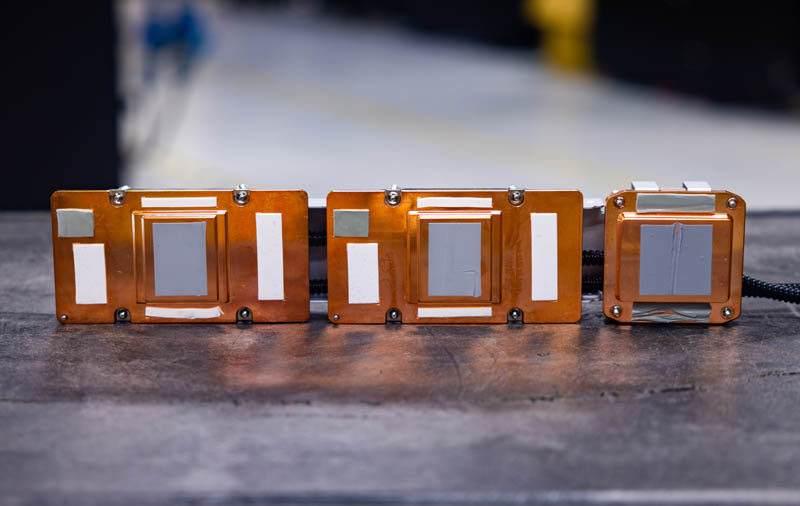

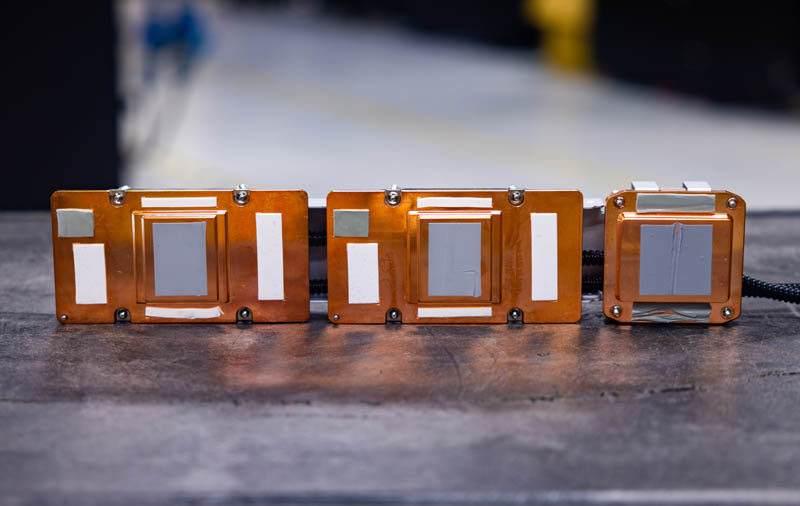

Два водоблока для CPU x86 в прототипе с SC-23 достаточно стандартные. Действительно уникальная вещь находится с правой стороны. Четыре переключателя PCIe Broadcom, которые сегодня используются почти во всех ИИ-серверах HGX, установлены прямо на материнской плате Supermicro, вместо отдельной платы. И для охлаждения этих PCIe переключателей Supermicro использует кастомные водоблоки. В других ИИ-серверах жидкостное охлаждение применяют как дополнение к воздушному. Дизайн Supermicro изначально опирается на жидкостное охлаждение, при этом все компоненты СЖО обеспечивает один производитель.

Здесь просматривается аналогия с автомобилями: одни изначально разрабатываются на базе двигателя внутреннего сгорания и дополнительно оснащаются электрической силовой установкой, в то время как электромобили сразу разрабатываются как электромобили. Сервер Supermicro аналогичен последним, тогда как другие серверы HGX H100 – первым. Мы имели дело со многими открытыми серверными платформами HGX H100/H200, а также с некоторыми решениями для гиперскейлеров. И с уверенностью заявляем: между этой системой Supermicro и другими, включая другие серверы от самой же Supermicro с опциональным воздушным/жидкостным охлаждением, – огромная разница.

С задней стороны стоек мы видим оптоволоконные подключения 400GbE комплексов GPU и CPU, а также меднопроводные подключения управляющих сетевых устройств. Эти сетевые карты также имеют собственные монтажные платы для облегчения их замены без снятия корпуса, но они находятся на задней панели корпуса. К каждому серверу подключено четыре блока питания, которые также поддерживают горячую замену и получают энергию от 3-фазных распределительных блоков (PDU).

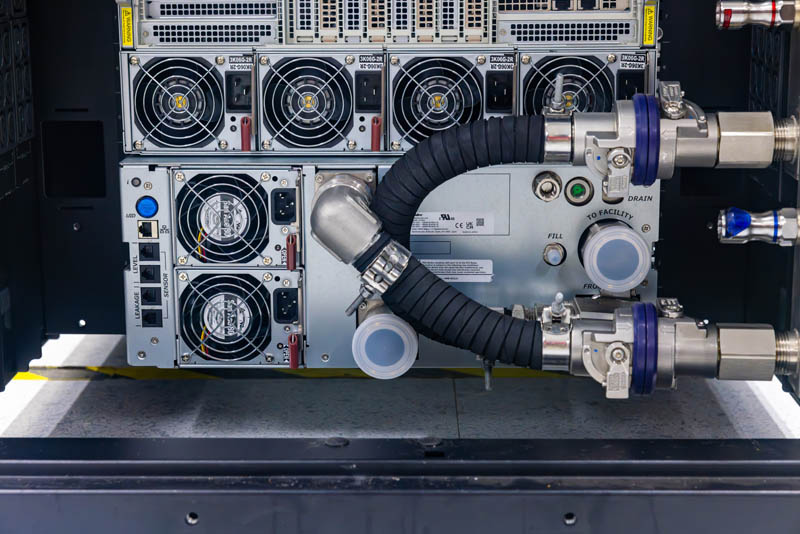

На самом нижнем этаже стойки мы находим блоки распределения хладагента (CDU, coolant distribution unit). Эти CDU работают как гигантские теплообменники. В каждой стойке имеется контур жидкостного охлаждения, который охватывает все графические серверы. Мы говорим – жидкостное охлаждение (не водяное), потому что обычно в таких контурах используется специальная жидкость, по своим характеристикам оптимально подходящая к материалам охлаждающих блоков («водоблоков»), трубопроводов и т.д.

Каждый CDU оснащен резервными помпами и блоками питания, так что, если какой-то из этих компонентов выйдет из строя, его можно будет заменить прямо на месте, не выключая стойку. Поскольку я однажды менял помпу в таком CDU, то подумал, не сделать ли это для интереса на Colossus. Потом я подумал, что это не самая лучшая идея, потому что у нас уже есть прошлогодний ролик, где я меняю помпу.

В стойках xAI много включенного оборудования, но в нашем фильме 2023 года более детально показан CDU Supermicro. Здесь вы можете видеть вход CDU и выходы для отработанного хладагента и хладагента, поступающего в трубопровод стойки. Также у каждого CDU вы можете видеть блоки питания с резервированием и поддержкой горячей замены.

На фото ниже – CDU стойки Colossus, загороженный трубами и проводами.

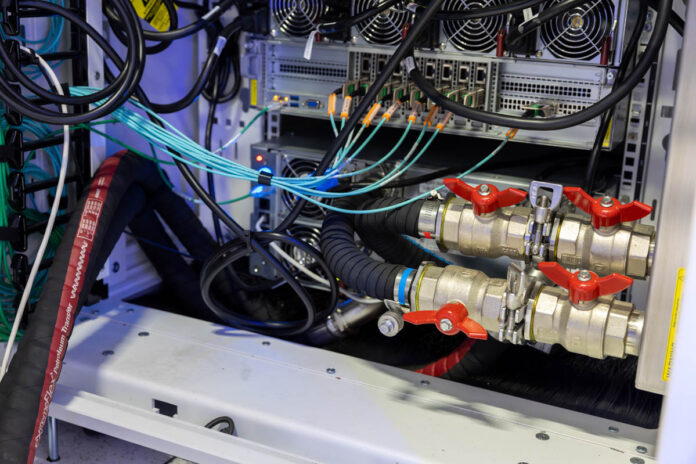

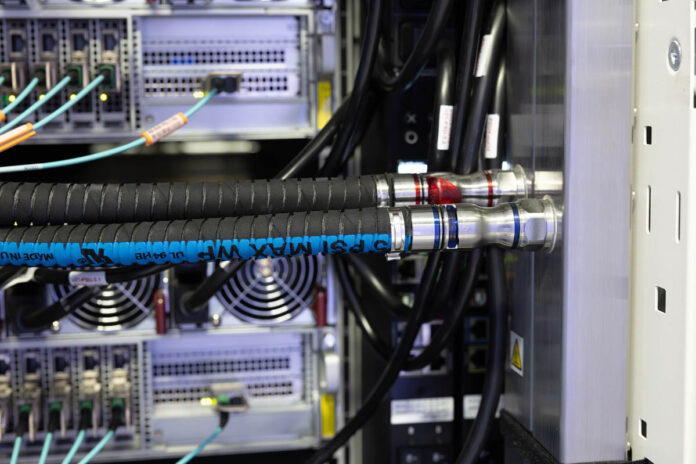

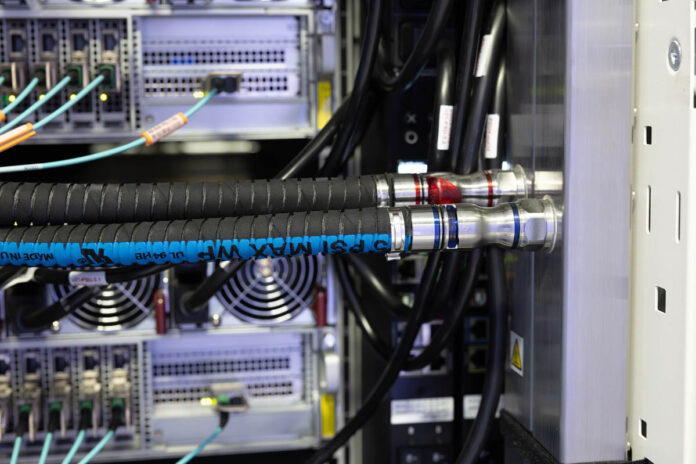

С каждой стороны стойки Colossus мы видим трехфазные PDU и стоечные трубопроводы. Каждый из установленных спереди трубопроводов 1U, которые питают контуры охлаждения графических систем 4U Universal, в свою очередь питается от стоечного трубопровода, который соединен с CDU. Все эти компоненты промаркированы красными и синими фитингами. К счастью, это привычная схема цветовой маркировки, где красный обозначает часть контура с теплой водой, а синий – с холодной.

Вы, вероятно, обратили внимание, что на этих фото все-таки присутствуют вентиляторы. Вентиляторы используются во многих серверах с жидкостным охлаждением для охлаждения таких компонентов, как DIMM, блоки питания, малопотребляющие BMC-контроллеры, сетевые карты и т.д. В Colossus каждую стойку нужно охлаждать до комнатной температуры, чтобы не прибегать к установке массивных кондиционеров. Вентиляторы в серверах тянут более прохладный воздух со стороны фронтальной плоскости стойки и выбрасывают его со стороны задних панелей серверов. Далее воздух проходит через теплообменник задней дверцы стойки.

Хотя термин «теплообменники задней дверцы» может звучать забавно, они правда работают аналогично автомобильному радиатору. Нагретый воздух из стойки пропускается через прорези теплообменника/ радиатора. В теплообменниках циркулирует хладагент, как и в контурах СЖО серверов, который отводит тепло в общий контур водяного охлаждения вычислительного центра. Воздух прокачивается через теплообменники с помощью вентиляторов. В отличие от обычных автомобильных радиаторов, эти теплообменники имеют одну хитрую особенность. В штатном режиме работы они подсвечиваются синим. Также они могут подсвечиваться другими цветами, например, красным, если возникает какая-либо техническая проблема. Когда я был на одном из строящихся участков, то видел, как при запуске стоек теплообменники мигали разными цветами.

Роль теплообменников задней дверцы в охлаждении залов вычислительного центра не ограничивается отводом тепла от графических серверов Supermicro с СЖО; они также отводят тепло от массивов накопителей СХД, вычислительных кластеров CPU и сетевых устройств.

СХД Supermicro в xAI

Серверы хранения данных (СХД) здесь действительно интересные. В кластерах ИИ большие массивы накопителей – обычное зрелище. В части хранения данных мы имели дело с программным обеспечением от разных производителей, но почти каждый сервер хранения данных из наших обзоров – также от Supermicro. И это неудивительно. Supermicro является OEM-партнером многих производителей накопителей.

Что нас отдельно впечатлило во время экскурсии по вычислительному центру – то, насколько некоторые СХД внешне похожи на вычислительные серверы на базе CPU.

И в том и в другом случае вы увидите на наших фото большое количество 2.5-дюймовых дисковых отсеков NVMe. Вообще, крупные ИИ-кластеры переходят с жестких дисков на SSD, поскольку последние обеспечивают значительную экономию энергии, предлагая в то же время бОльшую производительность и бОльшую плотность данных. Петабайт флэш-памяти, возможно, стоит дороже, но в кластерах такого масштаба она уже становится более выгодным решением с точки зрения TCO (совокупной стоимости владения системой).

Вычислительные серверы Supermicro на CPU в xAI

Во всех подобных кластерах обычно можно увидеть солидное представительство традиционных вычислительных нод на чипах CPU. Сценарии обработки и манипуляций с данными по-прежнему предпочтительнее запускать на CPU, чем на GPU. Кроме того, это позволяет высвободить ресурсы GPU для тренировки ИИ или запуска инференсов.

Здесь мы видим стойки одноюнитовых серверов. Каждый из них спроектирован с соблюдением баланса плотности вычислений и сопутствующего тепловыделения. Это видно по оранжевым биркам на отсеках для NVMe накопителей, а также по тому, что около трети площади передней панели выделено под забор воздуха для охлаждения системы.

Эти вычислительные серверы 1U могут охлаждаться вентиляторами, после чего отработанный воздух проходит через теплообменники задней дверцы, которые передают излишки тепла в общий контур водяного охлаждения вычислительного центра. Благодаря архитектуре стоек с теплообменниками задней дверцы в xAI могут применяться оба вида охлаждения, и жидкостное, и воздушное.

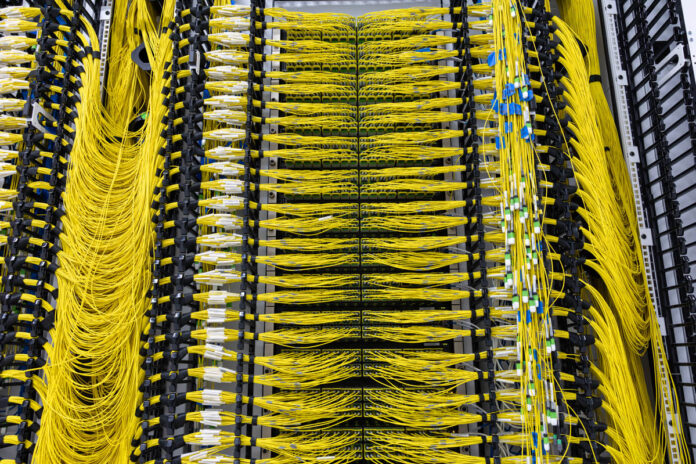

Сетевое оборудование xAI Colossus

Сетевая инфраструктура – один из самых замечательных компонентов этого вычислительного центра. Если ваш компьютер оснащен кабелем Ethernet, радуйтесь – эта сетевая технология является основной и здесь. С той только разницей, что здесь каждое оптическое подключение – 400GbE – в 400 раз быстрее обычного 1GbE, которые мы встречаем повсеместно. Здесь также используется девять таких линков на систему, что обеспечивает пропускную способность около 3.6 Тбит/с на каждый графический сервер.

Большую часть этой пропускной способности несет сеть RDMA для графических ускорителей. Каждый GPU имеет свою сетевую карту. В xAI используются умные сетевые карты с DPU NVIDIA BlueField-3 и коммутаторы NVIDIA Spectrum-X. У NVIDIA есть специальная линейка сетевых решений для ИИ, которые помогают направлять нужные данные в нужное место и избежать «пробок» в кластере.

Это мощное решение. Сети многих суперкомпьютеров используют InfiniBand или другие технологии, а здесь Ethernet. Ethernet означает масштабируемость. Любой наш читатель получит эту статью так или иначе через сеть Ethernet. Ethernet – основа интернета. В итоге мы получаем потрясающую масштабируемость. В части масштабируемости эти гигантские ИИ-кластеры имеют такие возможности, какие даже близко не обеспечивают более экзотические сетевые технологии. Это действительно сильный ход команды xAI.

Помимо графической сети RDMA, подключения 400GbE также используют серверы на CPU, которые подключены к другой фабрике коммутаторов. Здесь xAI применяет стандартное для высокопроизводительных вычислительных кластеров решение, когда создается одна сеть для GPU и другая – для остальной части кластера.

Просто чтобы вы имели представление о скоростях 400GbE – одно такое подключение по пропускной способности превосходит все линии PCIe, которые может поддерживать топовый серверный процессор Intel Xeon начала 2021 года. И здесь эта пропускная способность еще девятикратно увеличена для каждого сервера.

Вся эта сетевая инфраструктура подразумевает использование кучи оптоволоконных кабелей. Каждый кабель имеет определенную длину и маркированные коннекторы.

В августе у меня была возможность присутствовать при работах по прокладке кабелей в вычислительном центре. Кабель-менеджмент в таких масштабах всегда впечатляет.

Помимо высокоскоростных сетей собственно вычислительного кластера, в xAI также используются менее скоростные сети, включающие в себя различные интерфейсы управления и вспомогательные устройства, которые входят в состав оборудования любого большого вычислительного центра.

Что было совершенно очевидно во время прогулки по этому кластеру, так это острая потребность в жидкостном охлаждении сетевых коммутаторов. Недавно мы делали обзор 64-портового коммутатора 800GbE, который относится к тому же классу 51.2T, что и используемые во многих ИИ-кластерах. Отрасль нуждается в решении проблемы охлаждения не только коммутирующего чипа, но также оптических модулей, которые в современных коммутаторов могут потреблять значительно большую мощность (и, соответственно, сильнее нагреваться), чем коммутирующий чип. Возможно, такие масштабные вычислительные сооружения подвигнут отрасль в сторону встроенной оптики, и жидкостное охлаждение коммутаторов пойдет по тому же пути, что и жидкостное охлаждение вычислительных машин. Мы уже видели демонстрационные образцы коммутаторов со встроенной оптикой и жидкостным охлаждением, и надеемся, что пример этого кластера послужит стимулом для вывода этих прототипов на стадию серийного производства.

Производственная инфраструктура Colossus

Поскольку мы имеем дело с жидкостным охлаждением стоек серверов для ИИ, энергетическая и водопроводная сети имеют для этого кластера ключевое значение. На фото ниже – водопроводные трубы. По одним протекает более холодная, по другим – более теплая вода. Холодная вода поступает в помещения вычислительного центра и через CDU – в каждую стойку. От водоблоков GPU и теплообменников задней дверцы нагревшаяся вода поступает также через CDU во внешний контур и далее в охладители. Конечно, это не такие охладители, в которых делают ледяные кубики. Здесь задача состоит только в том, чтобы понизить температуру воды достаточно для того, чтобы ее можно было снова запустить в контур охлаждения вычислительного центра.

Сеть энергоснабжения здесь солидная. Когда мы были в Мемфисе на еще строящемся объекте, то видели, как бригады рабочих устанавливали гигантские силовые кабели.

За пределами ВЦ мы увидели контейнеры с аккумуляторами Tesla Megapack. Это одно из действительно интересных решений, примененное при строительстве этого исполинского кластера. Серверы ИИ работают не на постоянной средней мощности в режиме 24х7, а с периодическими повышениями и понижениями потребляемой мощности. При таком большом количестве графических ускорителей потребляемая мощность флуктуирует в соответствии с загрузкой GPU, потом происходит сбор и сравнение результатов, после чего распределяются новые задания. Сотрудники ВЦ обнаружили, что миллисекундные всплески и спады в энергопотреблении являются достаточно сильным стрессовым фактором, и для демпфирования этих скачков включают в цепь Tesla Megapack в качестве промежуточных звеньев, повышающих надежность системы.

Конечно, это только первый этап строительства вычислительного центра. На момент нашего посещения был запущен кластер из четырех залов на 25000 графических ускорителей каждый, но производственные площади кластера растут быстрыми темпами.

По-видимому, скоро здесь будет нечто грандиозное.

Резюме

Один из основных выводов, который я сделал по итогам этой экскурсии, – у команды xAI много времени уходит на улаживание мелких нестыковок оборудования от разных поставщиков. Единственный способ получить результат в таких условиях – пригласить экспертов в области системной интеграции с четким видением концепции гигантского ИИ-кластера, работающего на сверхвысоких скоростях, что, очевидно, и было сделано. Если бы я увидел это в день первого посещения, то имел бы другое представление о том, сколько людей участвовало в совместной работе над проектом такого масштаба.

Участники ИИ-комьюнити сейчас говорят о том, как будут развиваться LLM в условиях роста аппаратного обеспечения и какое у них может быть применение, кроме использования в чат-ботах. Когда я был на Colossus, то подумал, что комплекс такого масштаба мог быть построен только при условии заинтересованности в этом бизнесов, извлекающих прибыль из больших данных. Grok и будущие ИИ-разработки xAI, судя по всему, эволюционируют в нечто намного большее, чем просто чат-боты образца 2024 года. Многие очень умные люди тратят кучу времени и денег на осуществление всего этого в максимально короткие сроки.

В конце концов, это просто фантастический опыт – видеть своими глазами этот уже запущенный кластер. Спасибо всем, кто проделал долгий путь к этому достижению.

Если вы работаете на большом ускорителе ИИ, напишите об этом. Быть на шаг впереди – это круто.

Подождите...

Подождите...